Note LLM learning

两个很清晰的介绍

来自李沐的介绍

Llama 3.1论文精读 · 1. 导言【论文精读·54】_哔哩哔哩_bilibili

Llama 3.1论文精读 · 2. 预训练数据【论文精读·54】_哔哩哔哩_bilibili

Llama 3.1论文精读 · 3. 模型【论文精读·54】_哔哩哔哩_bilibili

Llama 3.1论文精读 · 4. 训练infra【论文精读·54】_哔哩哔哩_bilibili

Llama 3.1论文精读 · 5. 模型训练过程【论文精读·54】_哔哩哔哩_bilibili

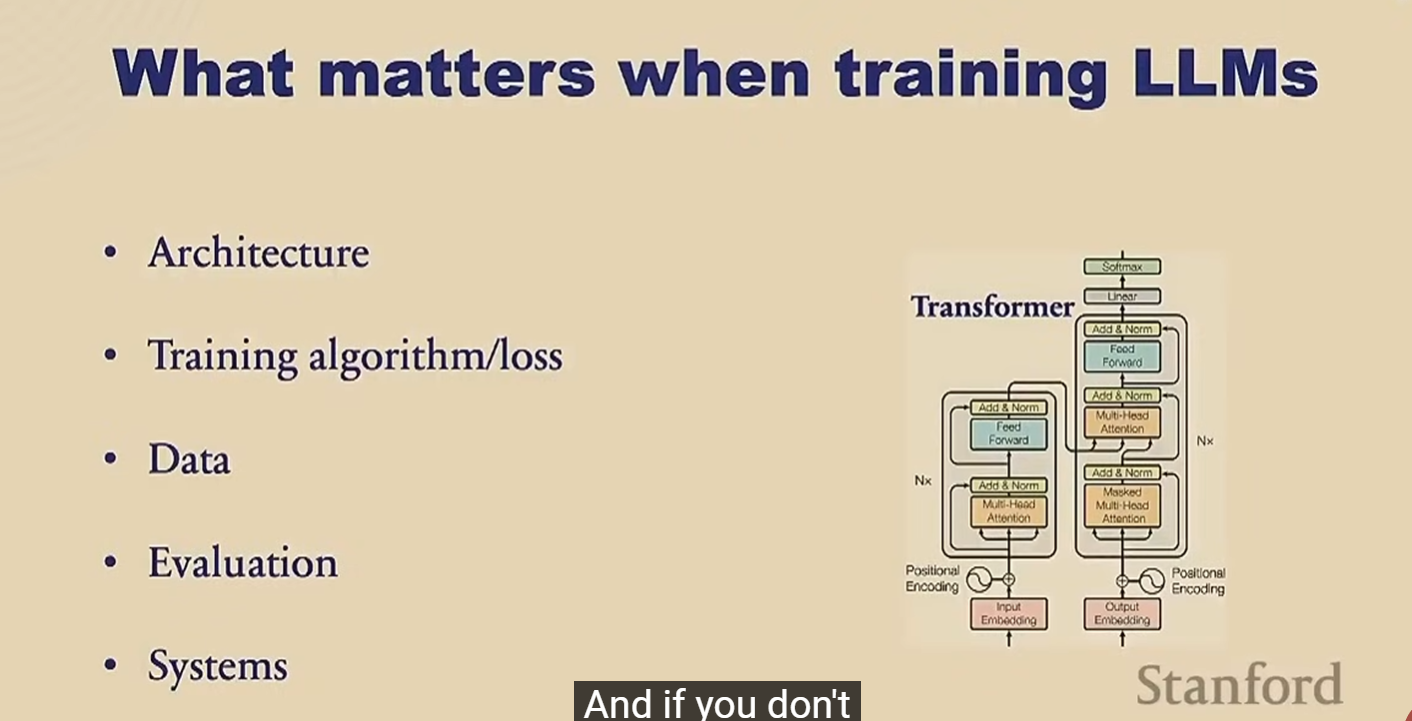

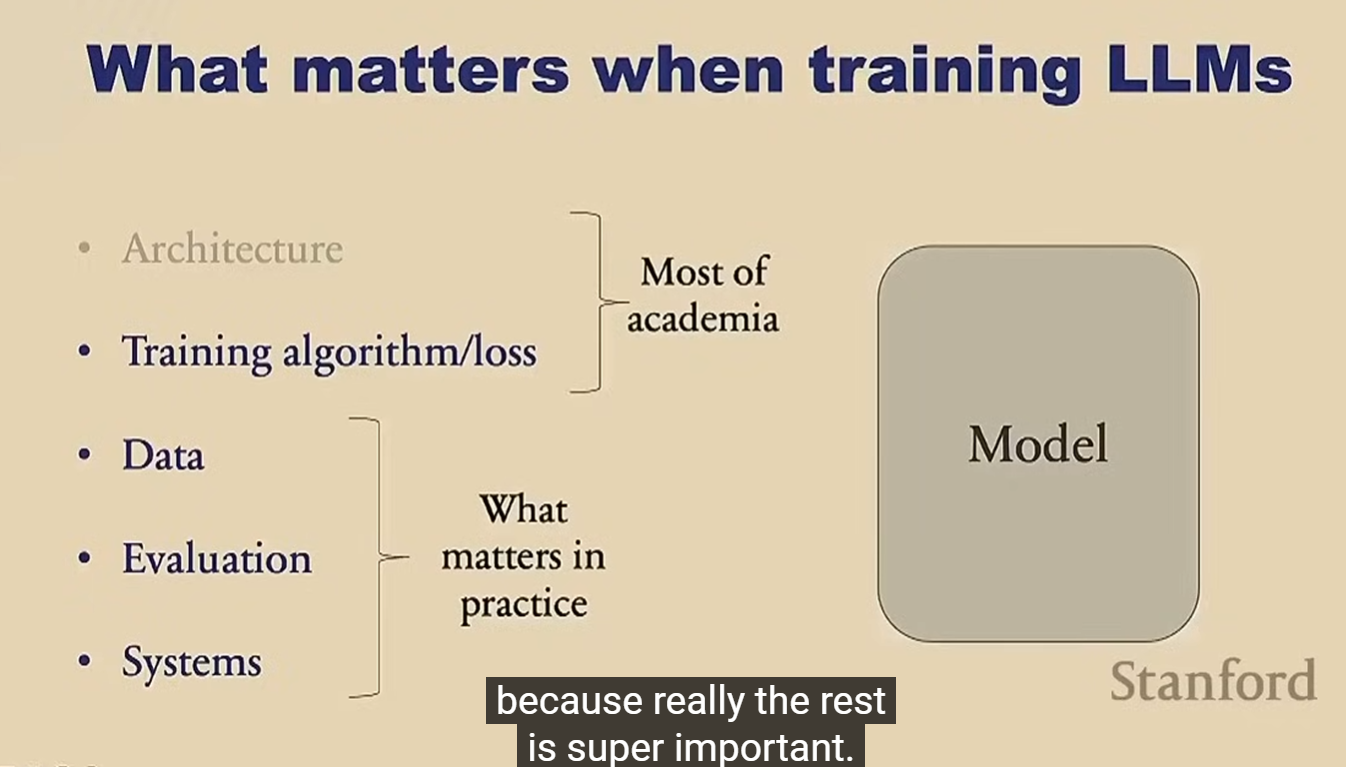

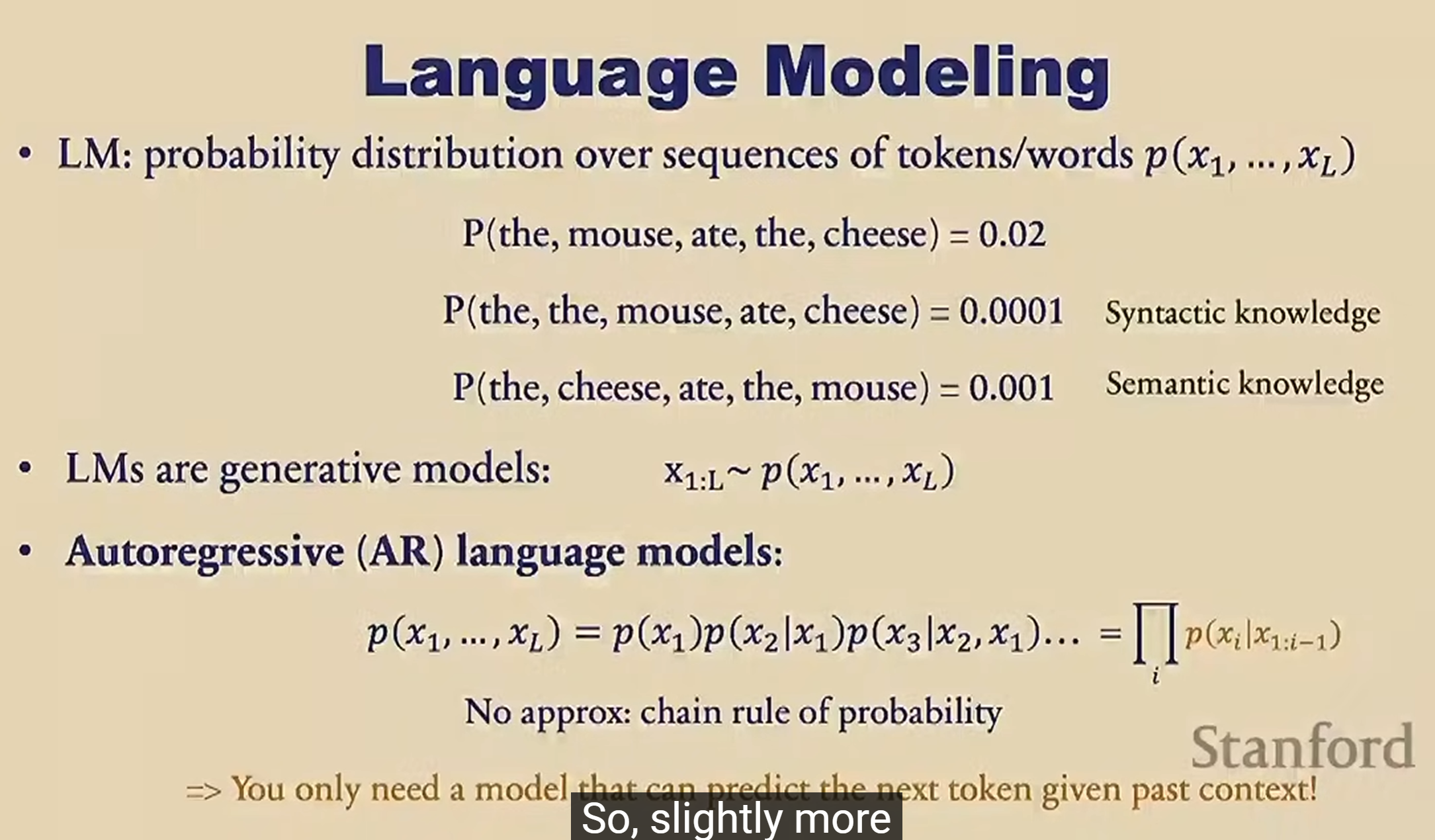

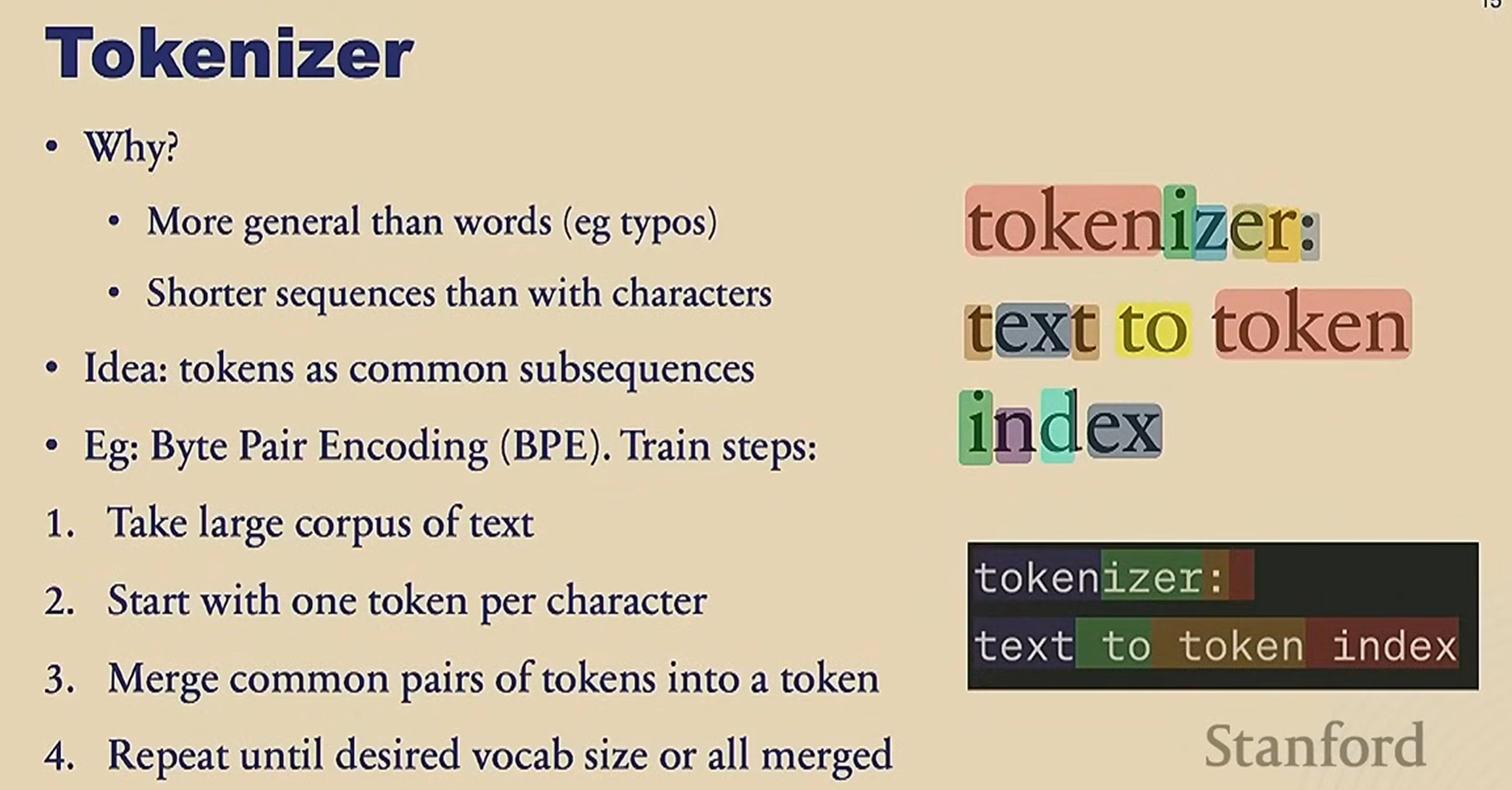

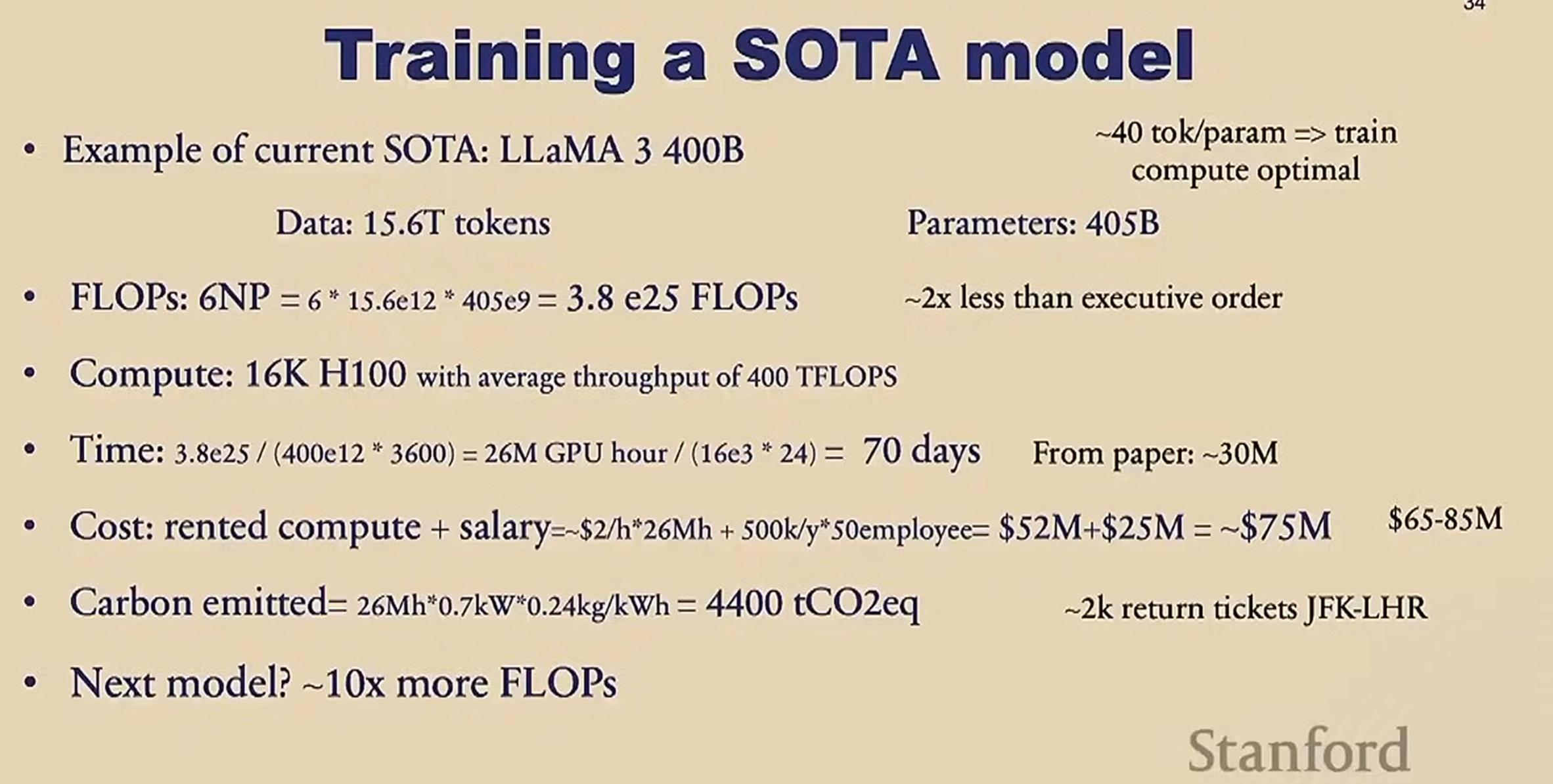

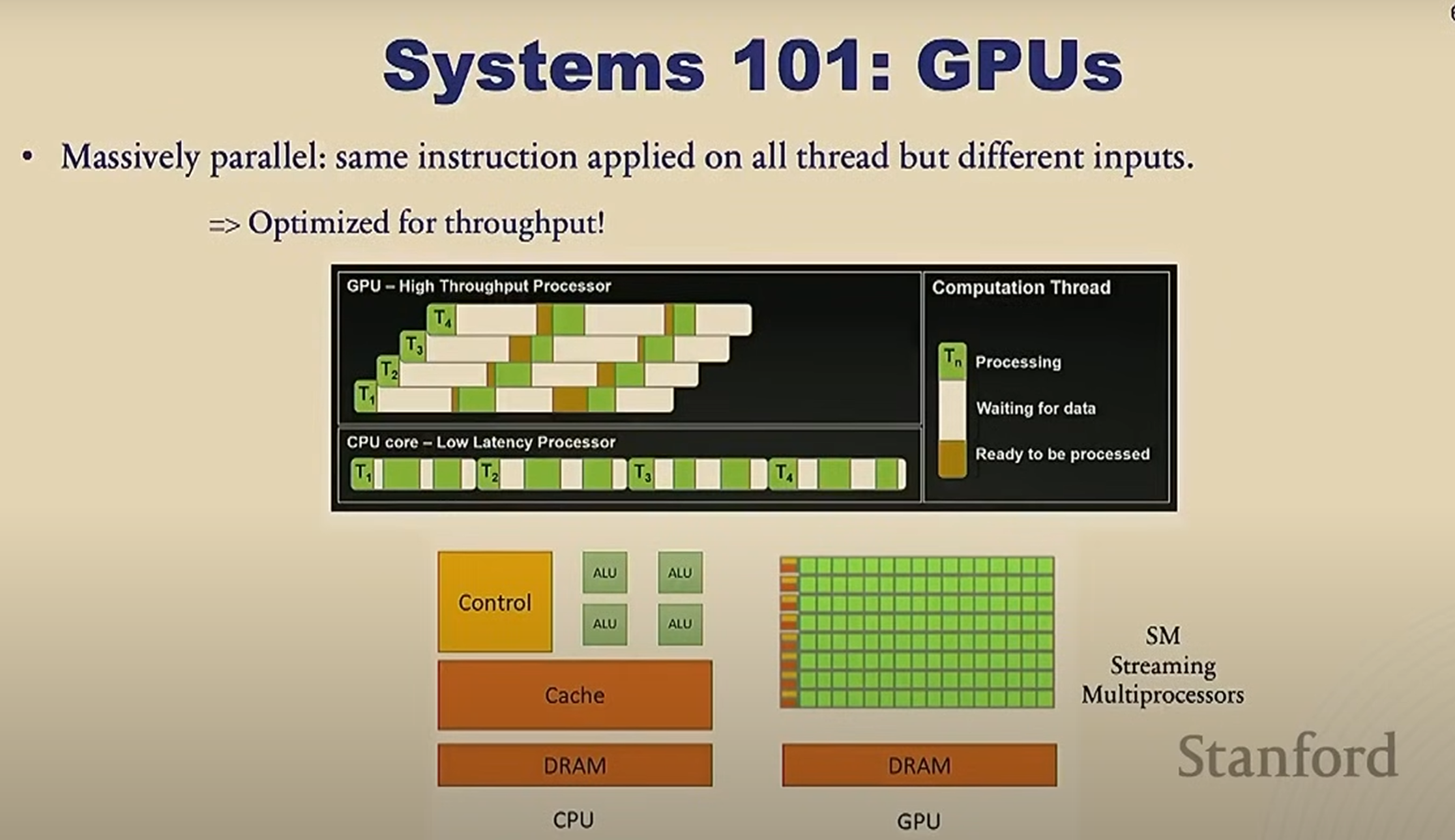

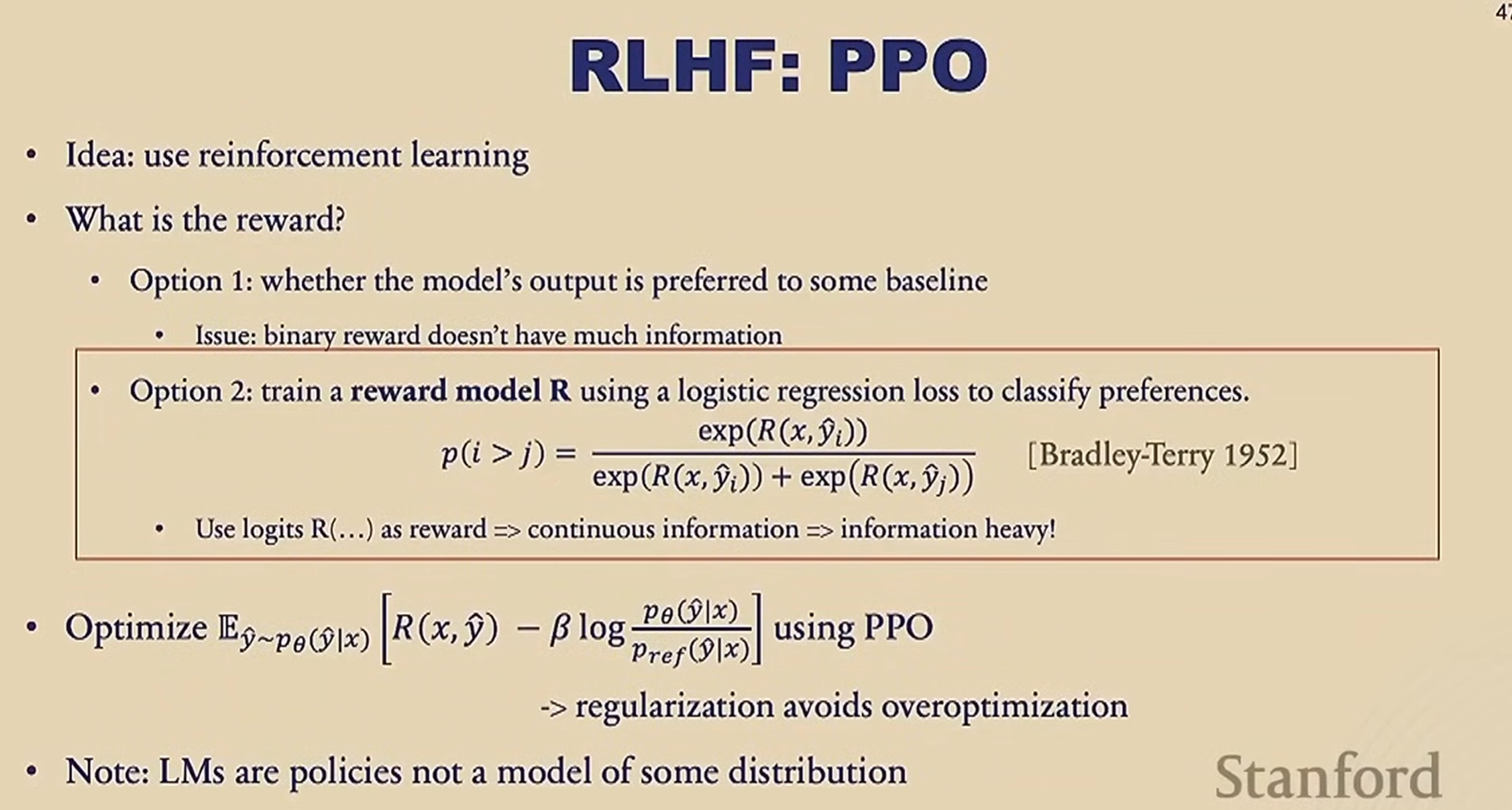

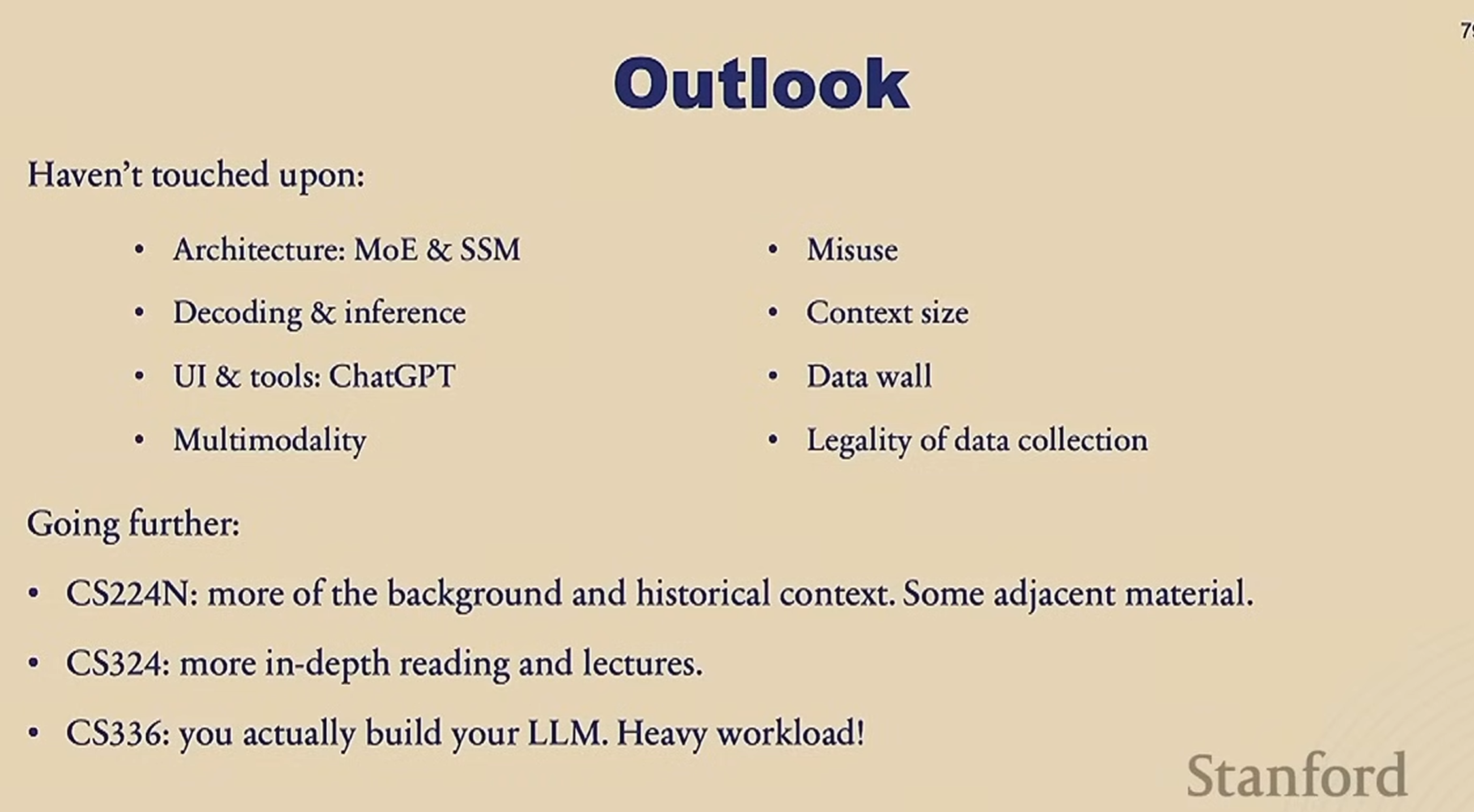

Stanford CS229 I Machine Learning I Building Large Language Models (LLMs)

视频链接

https://youtu.be/9vM4p9NN0Ts?feature=shared

课程PPT截图

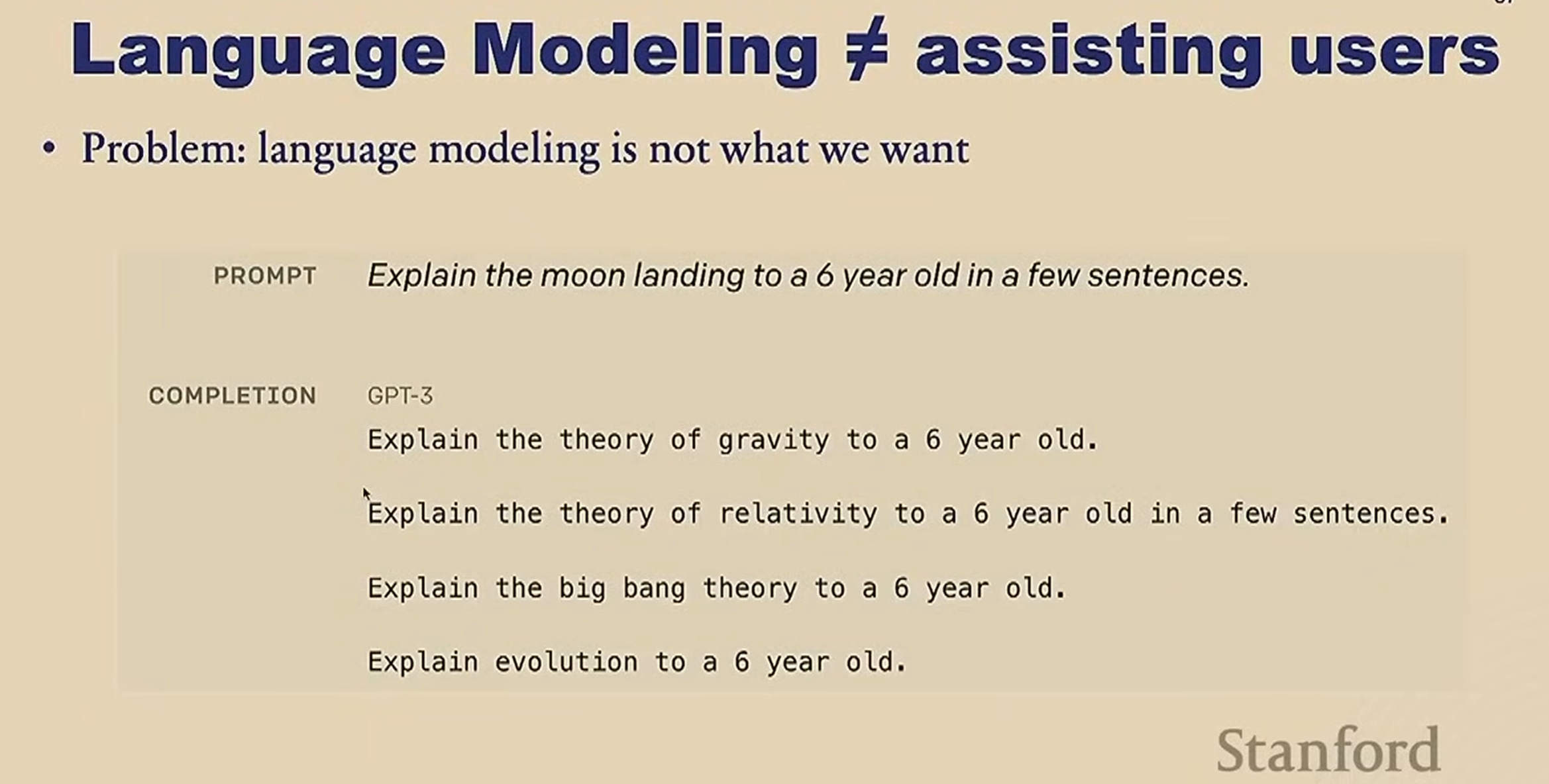

Pretraing

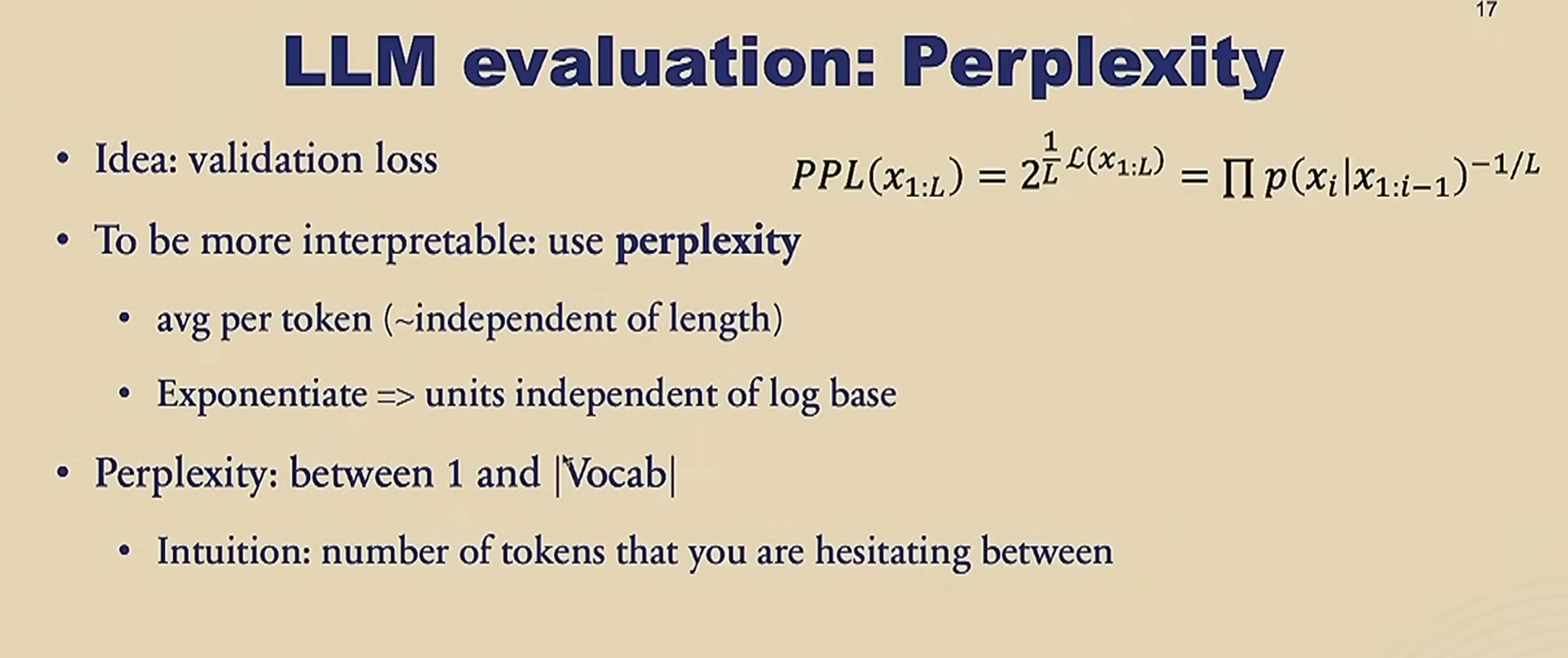

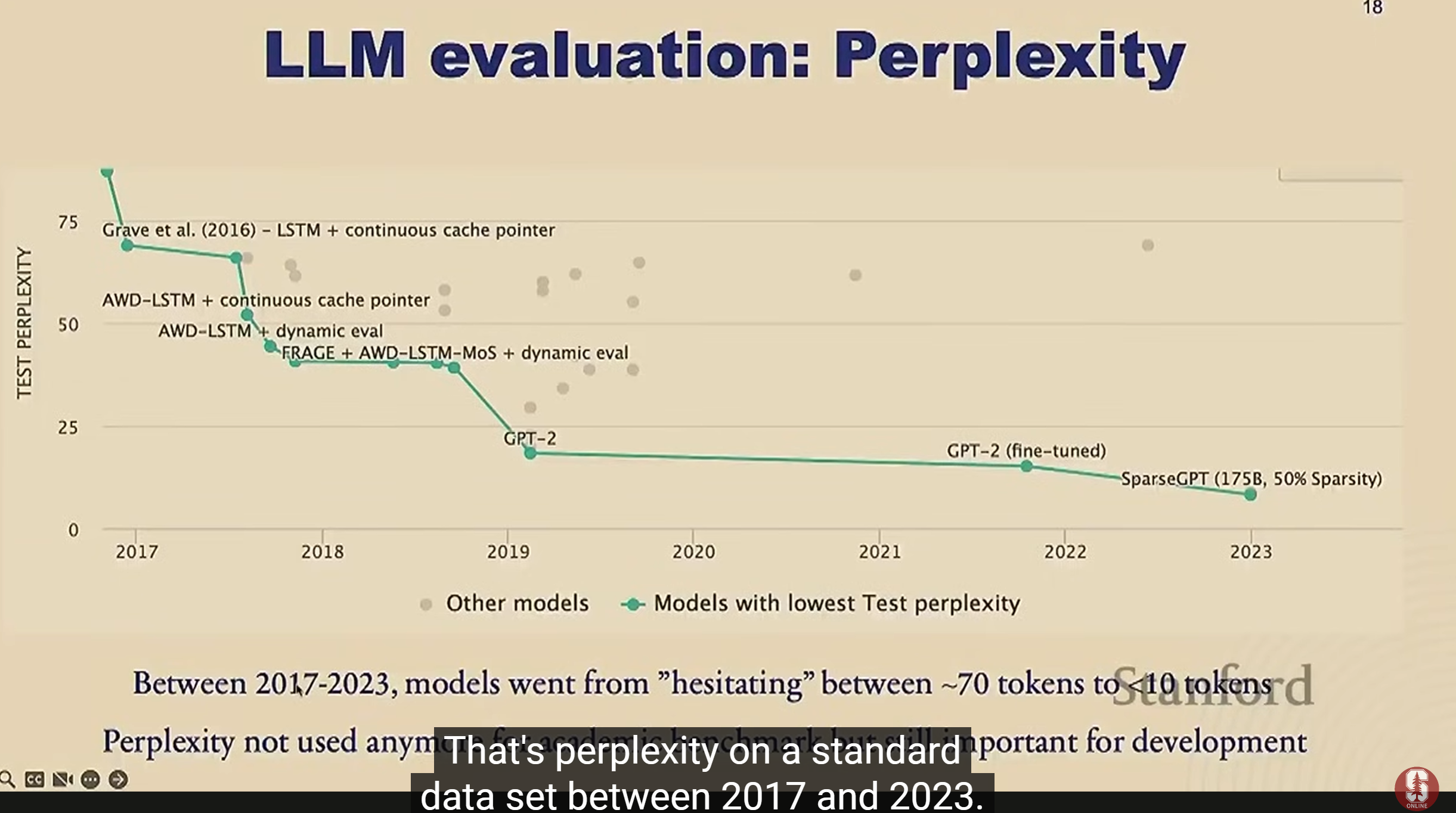

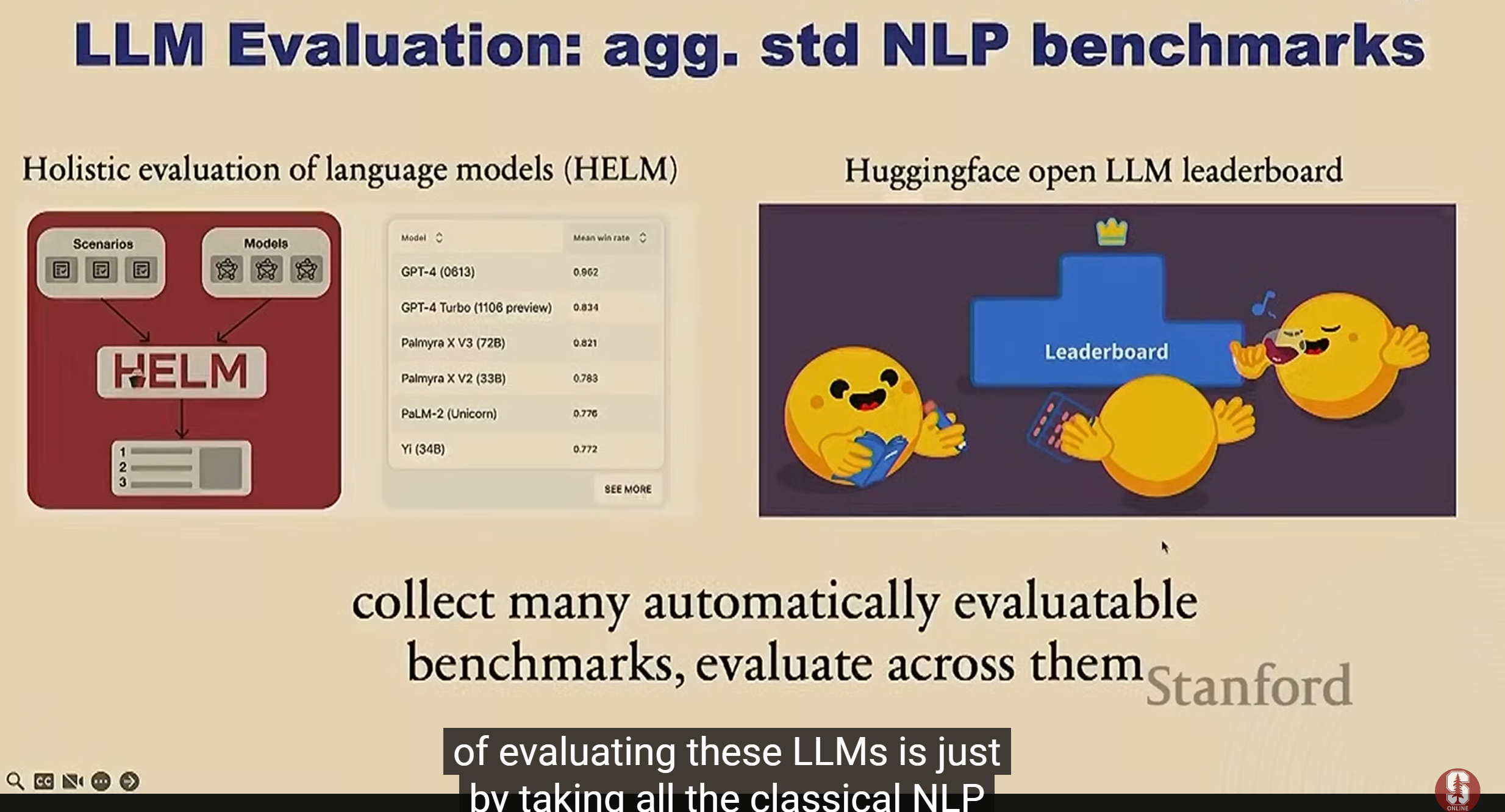

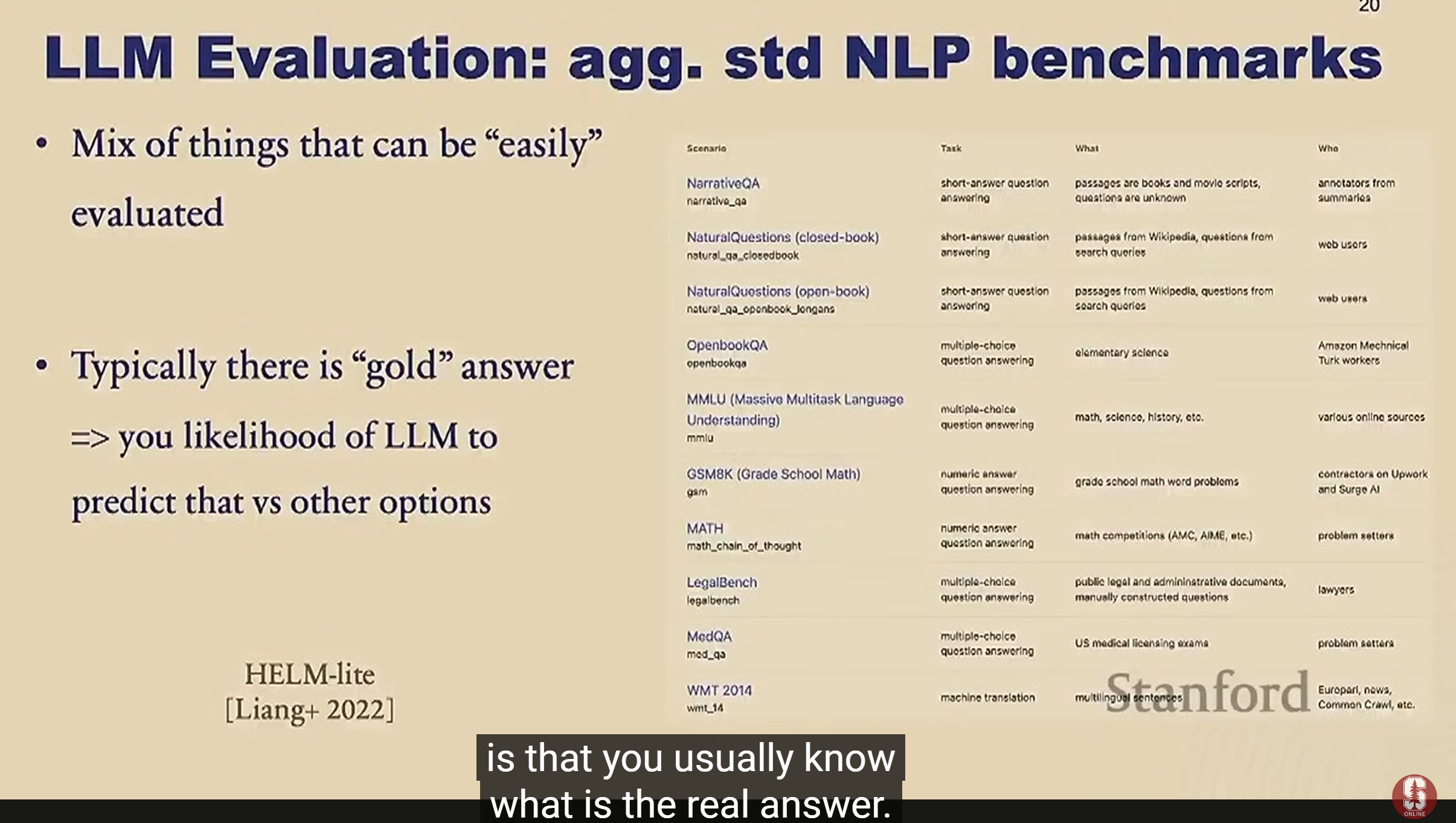

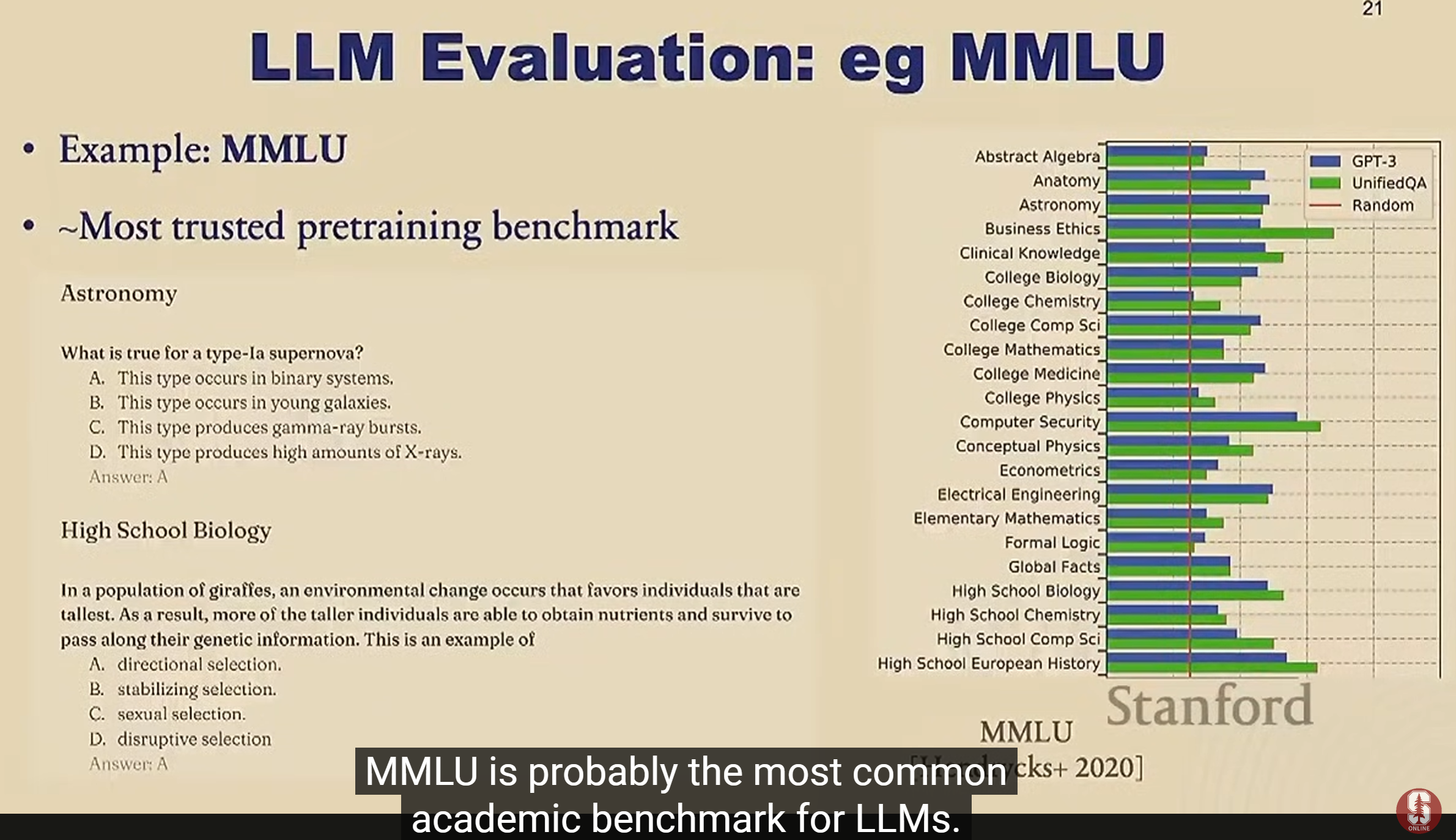

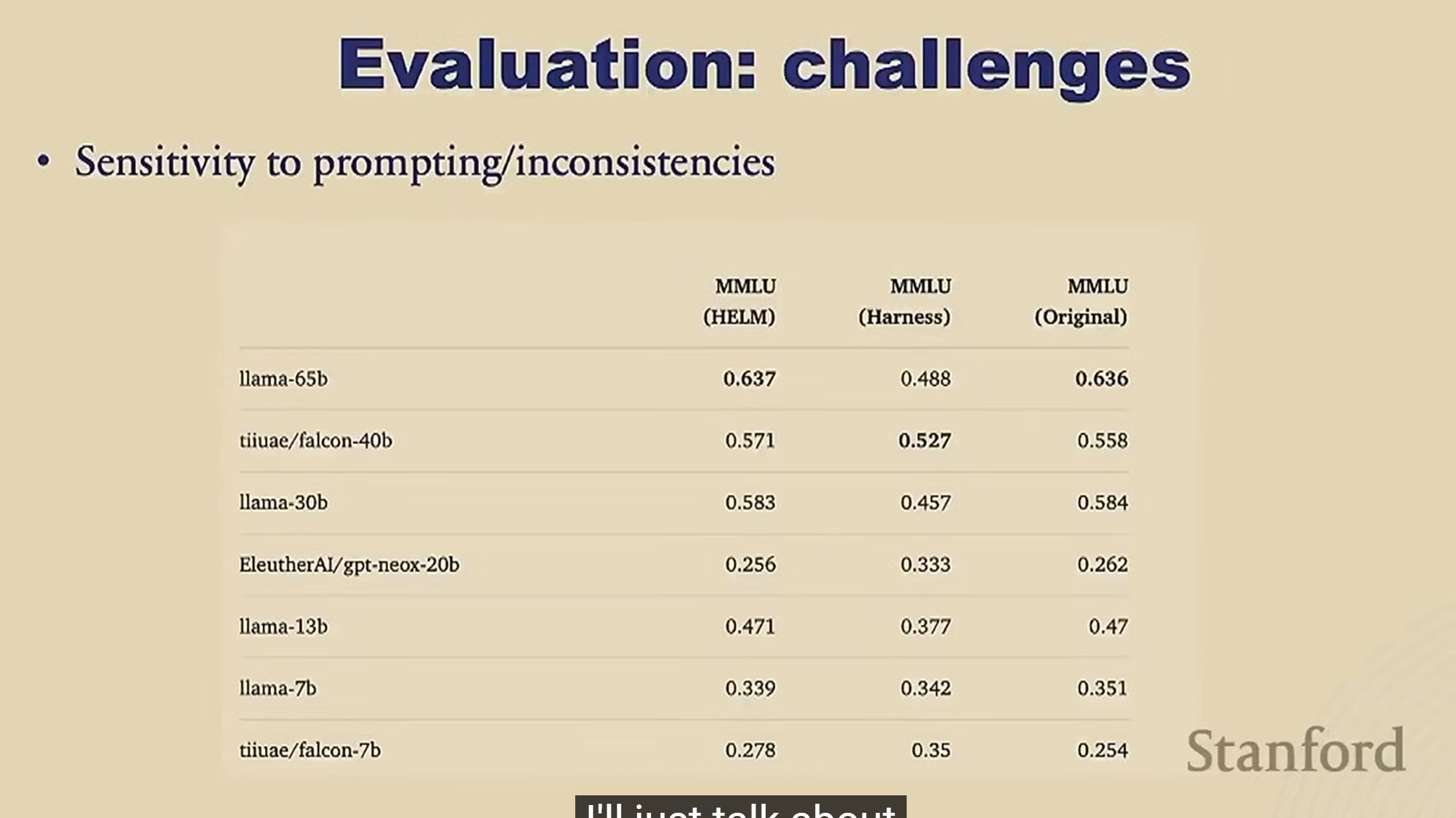

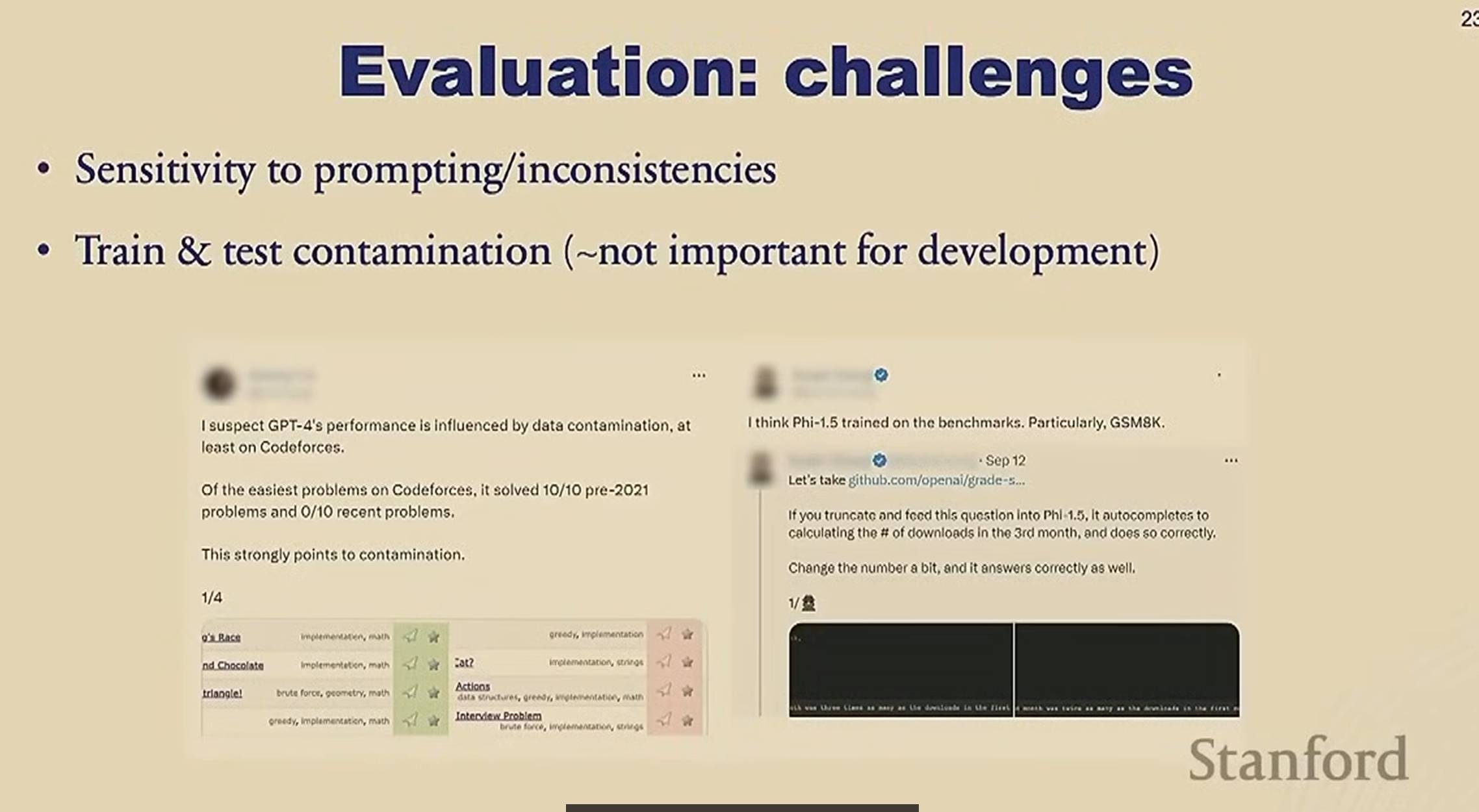

Evaluation

多选题 结果如果是 意思相同但是表达完全不一样的话怎么办

这里做的是让模型生成不同的答案,看不同的结果对应的 likehood 有什么区别 ,限制模型只能输出这四个模型

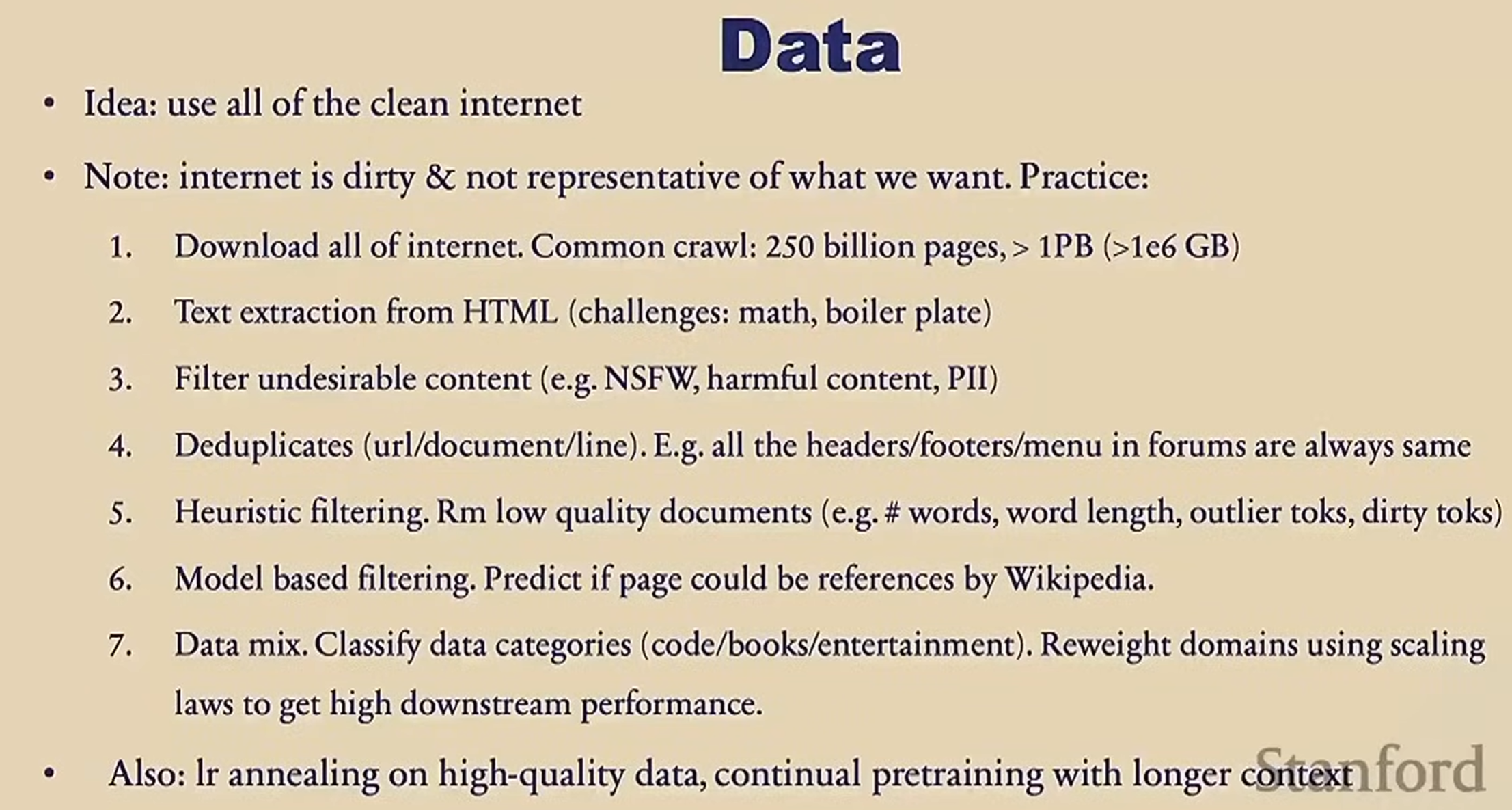

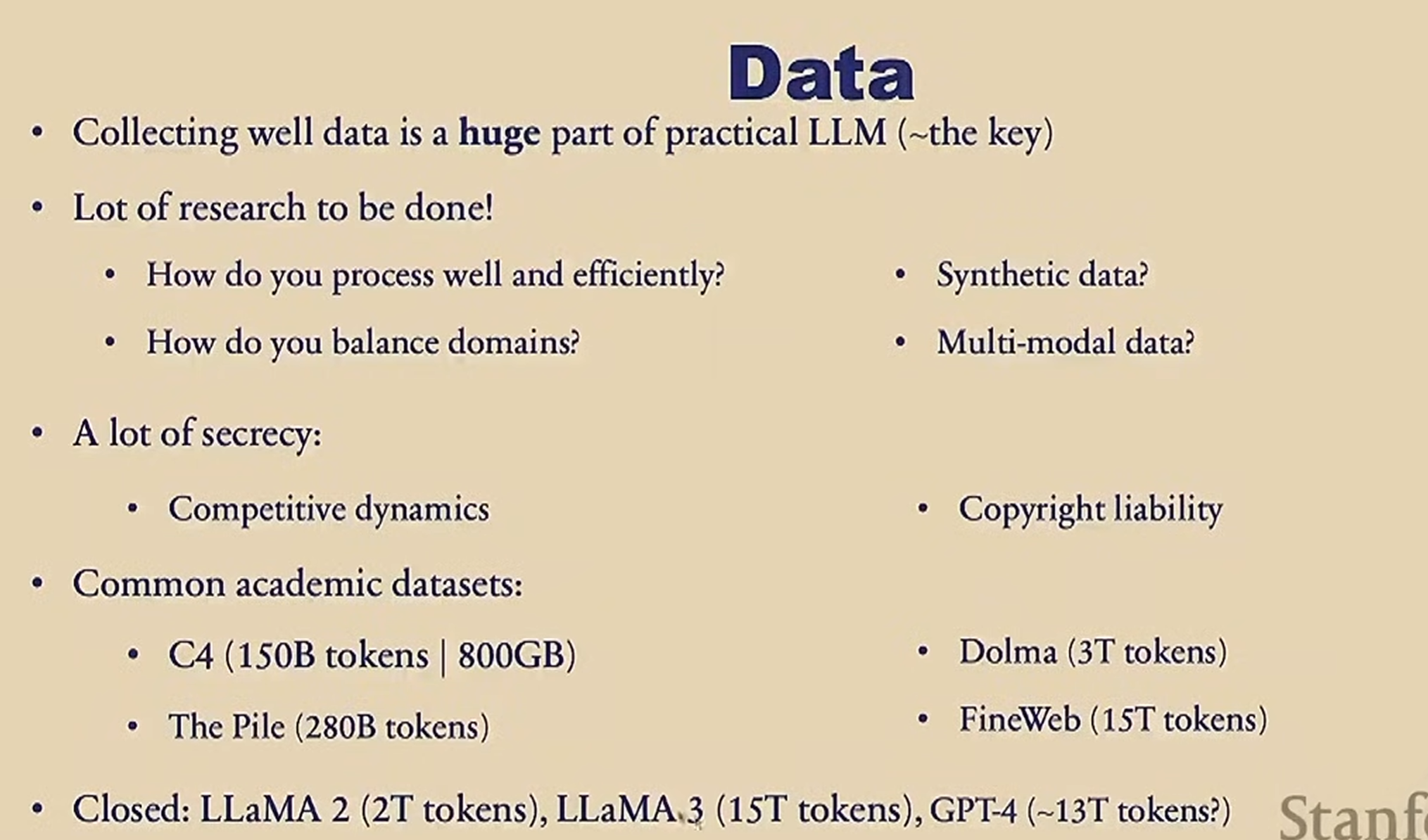

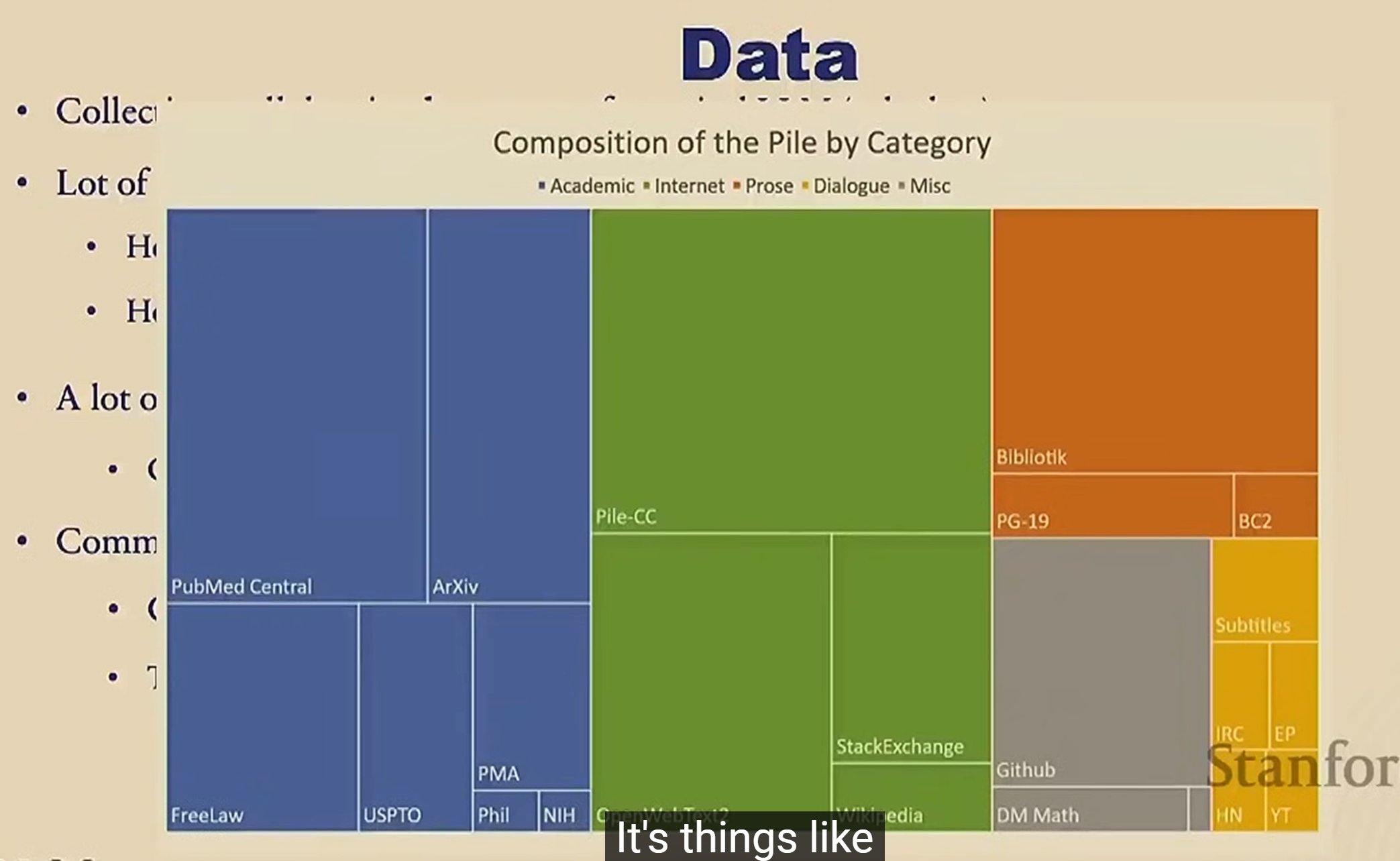

Data

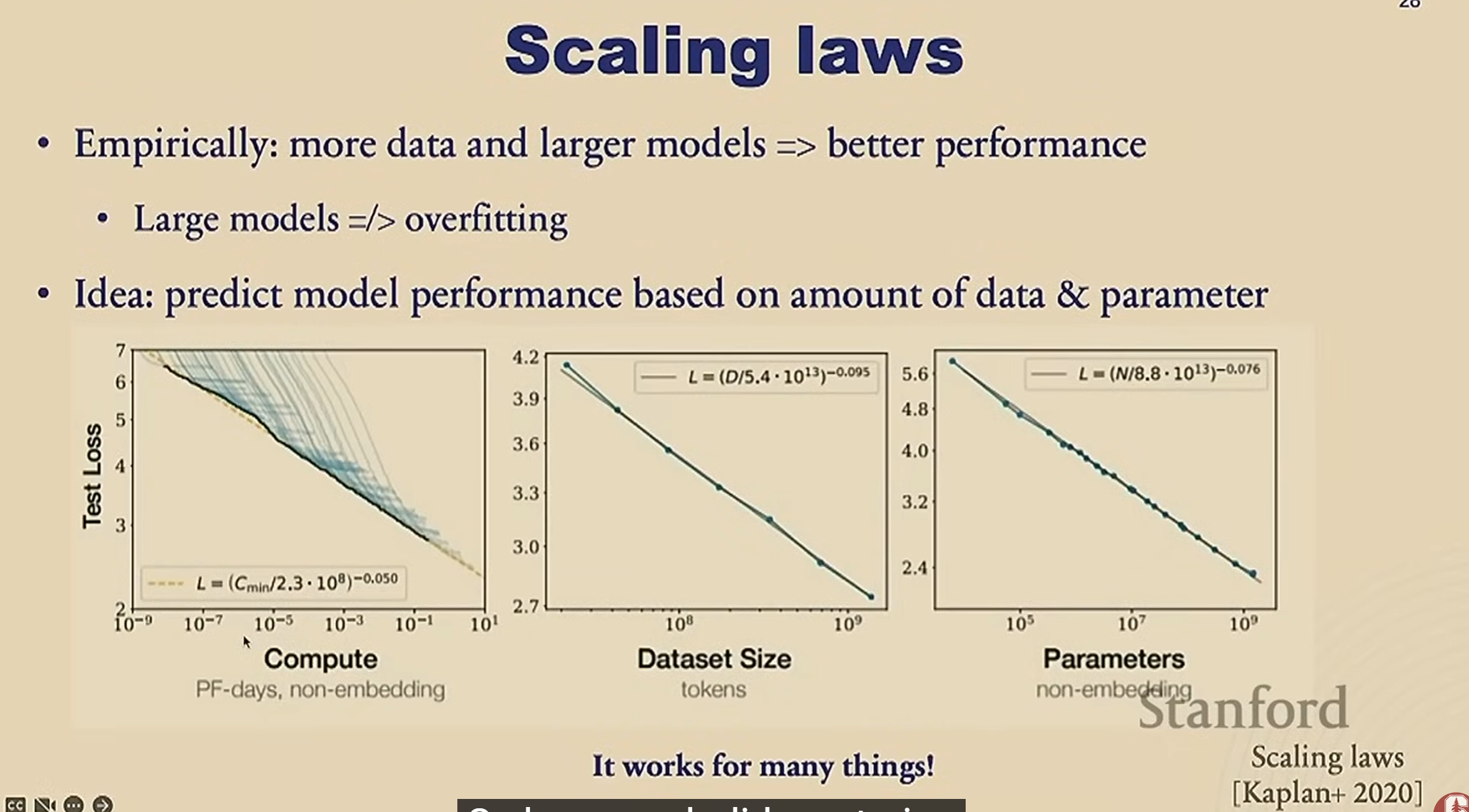

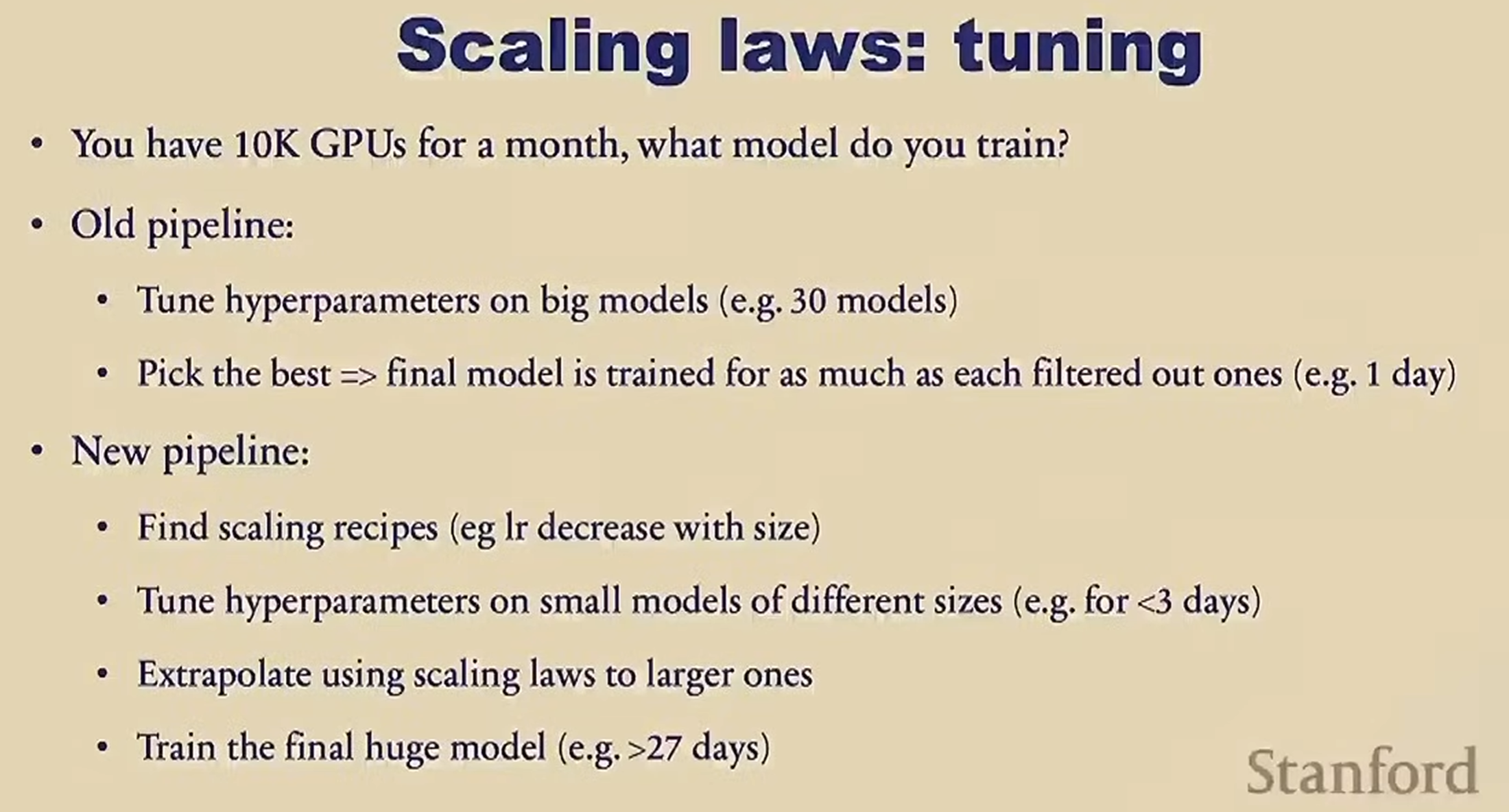

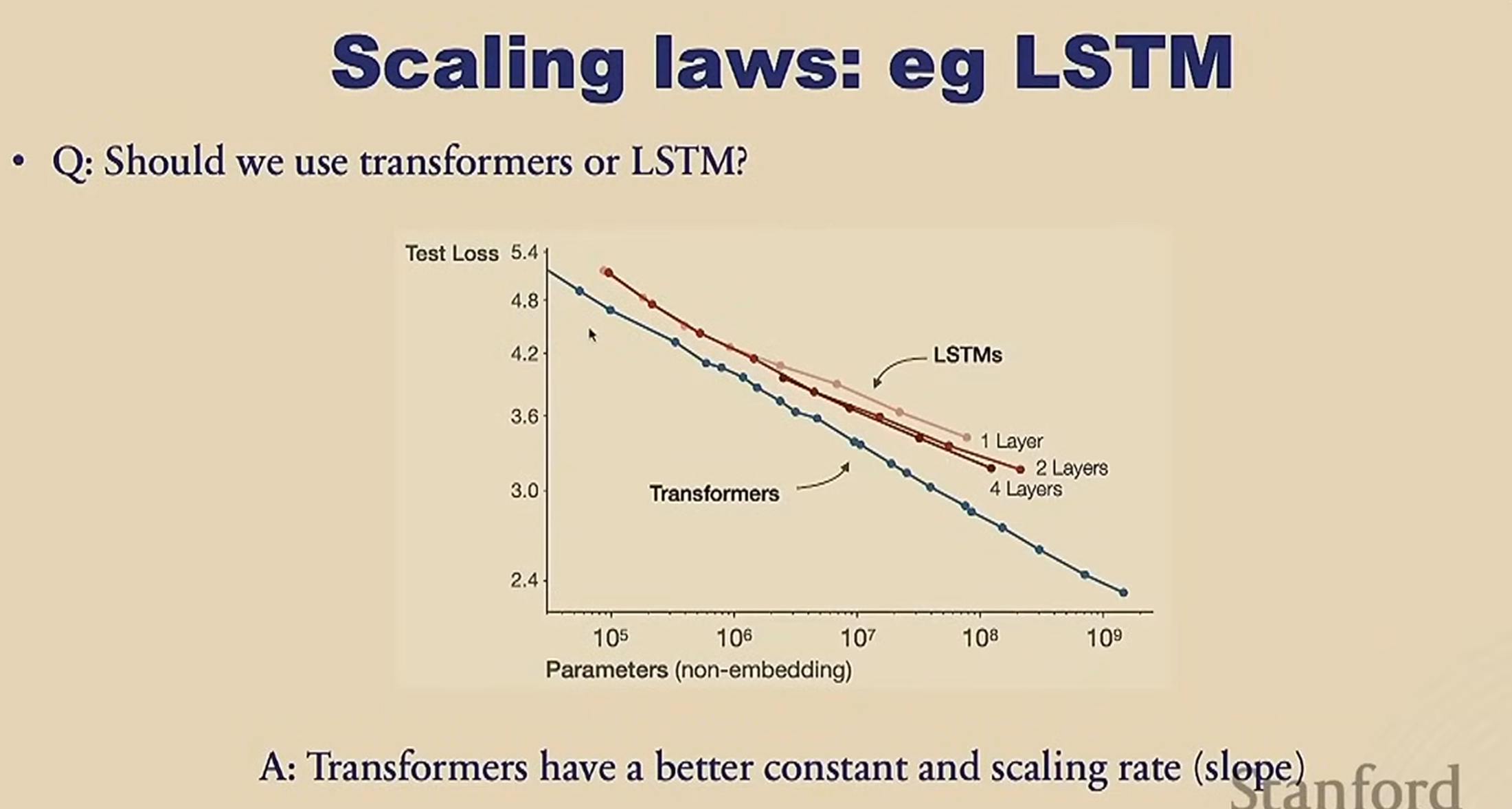

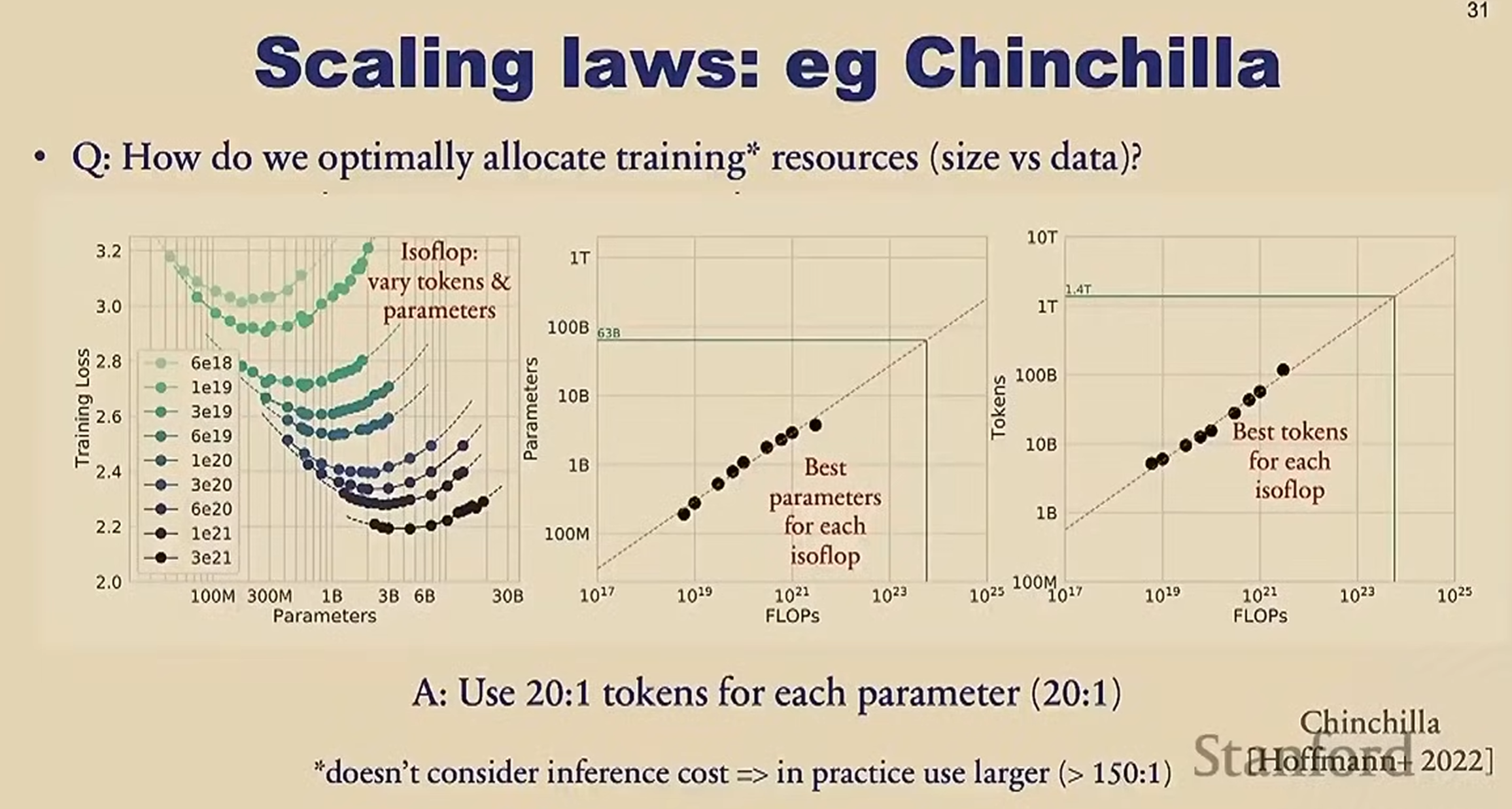

Scaling laws

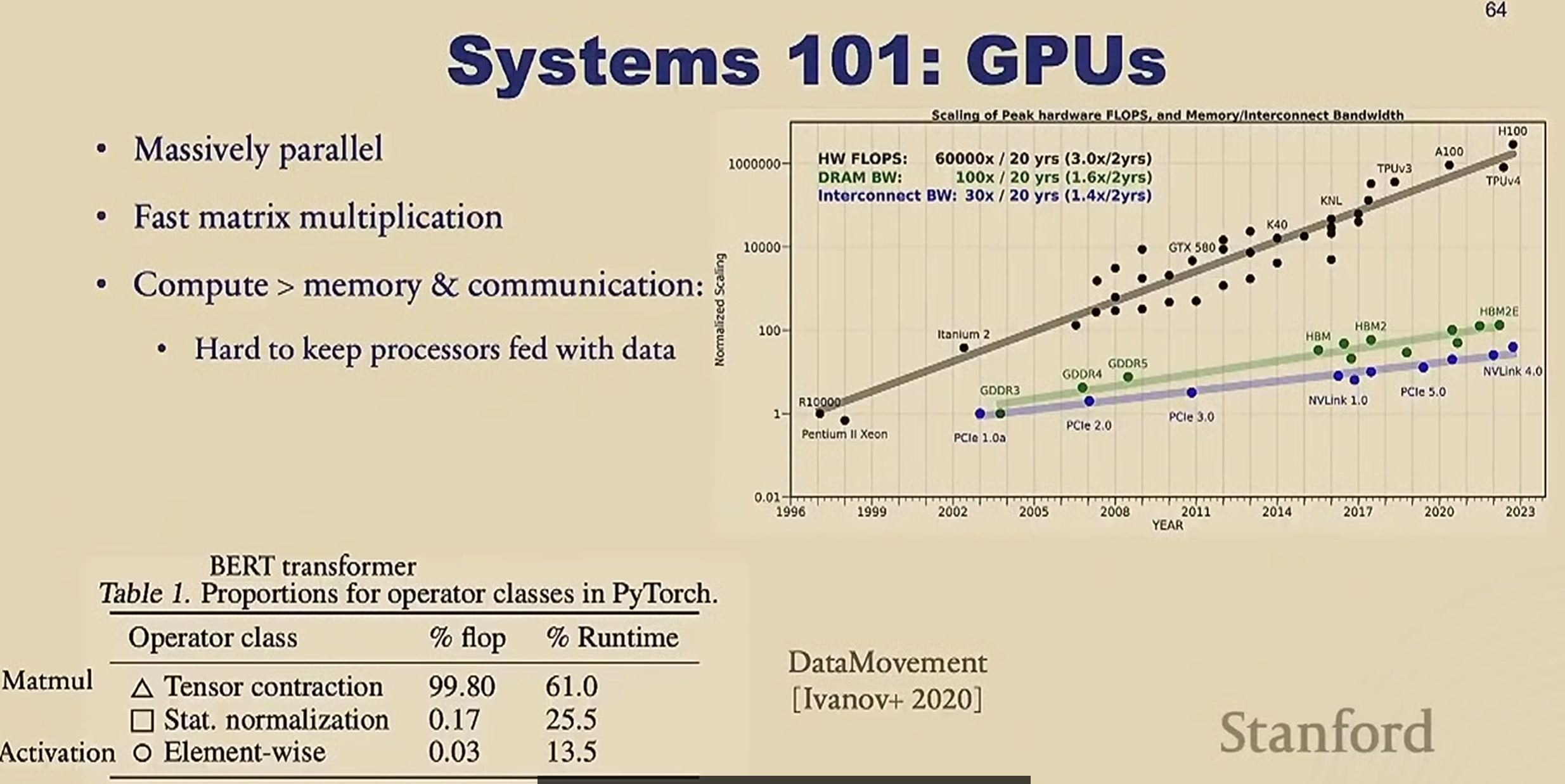

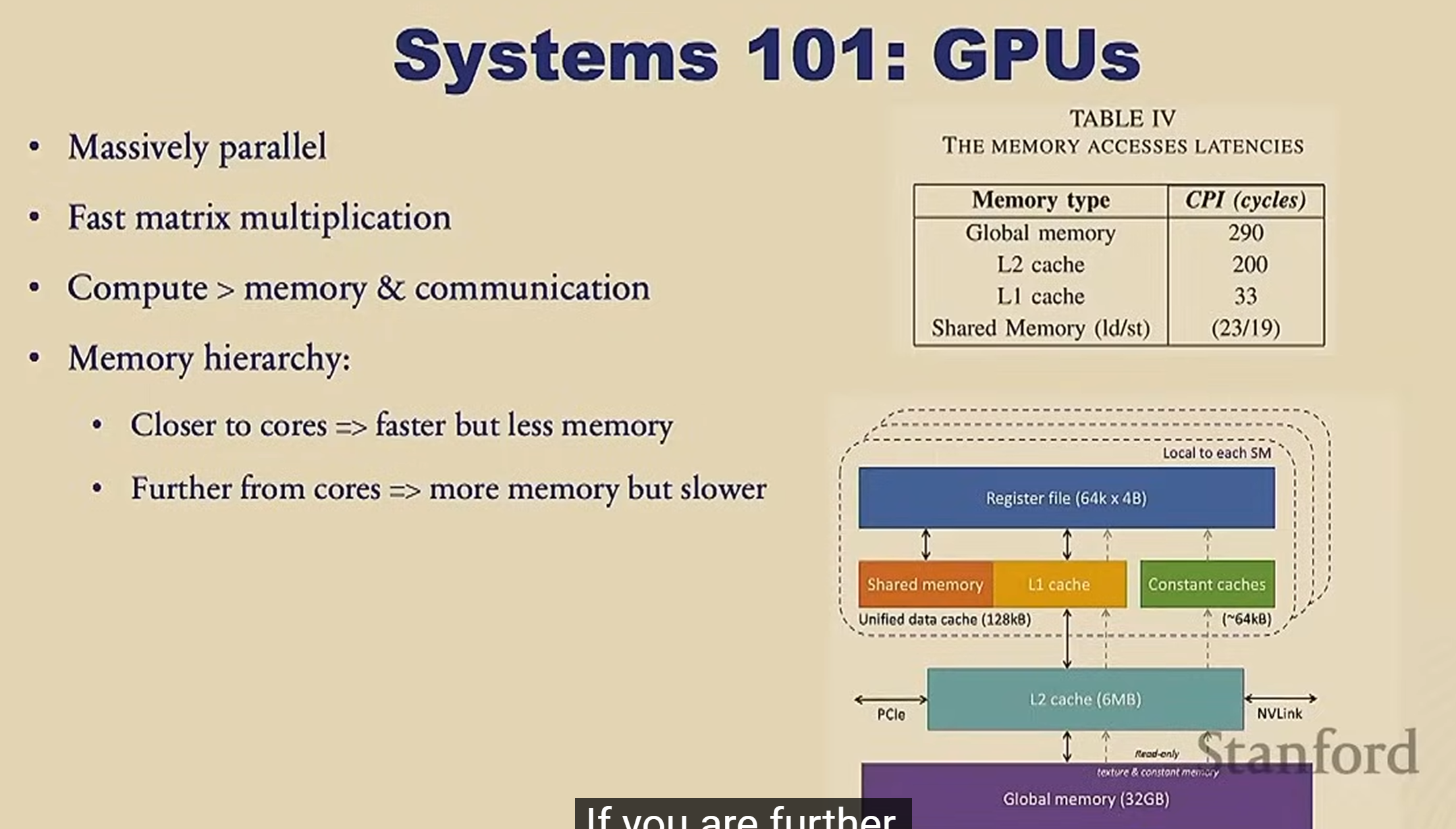

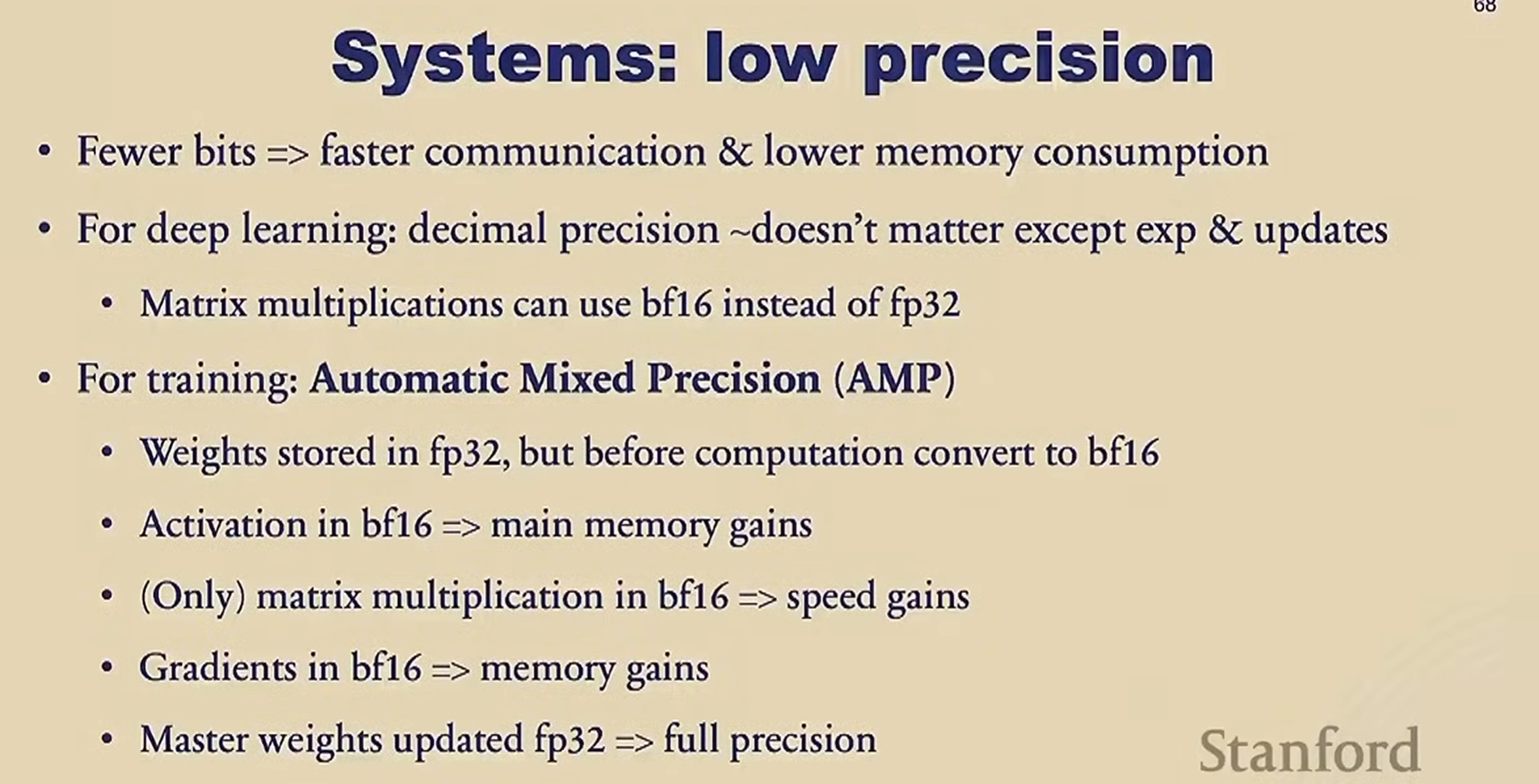

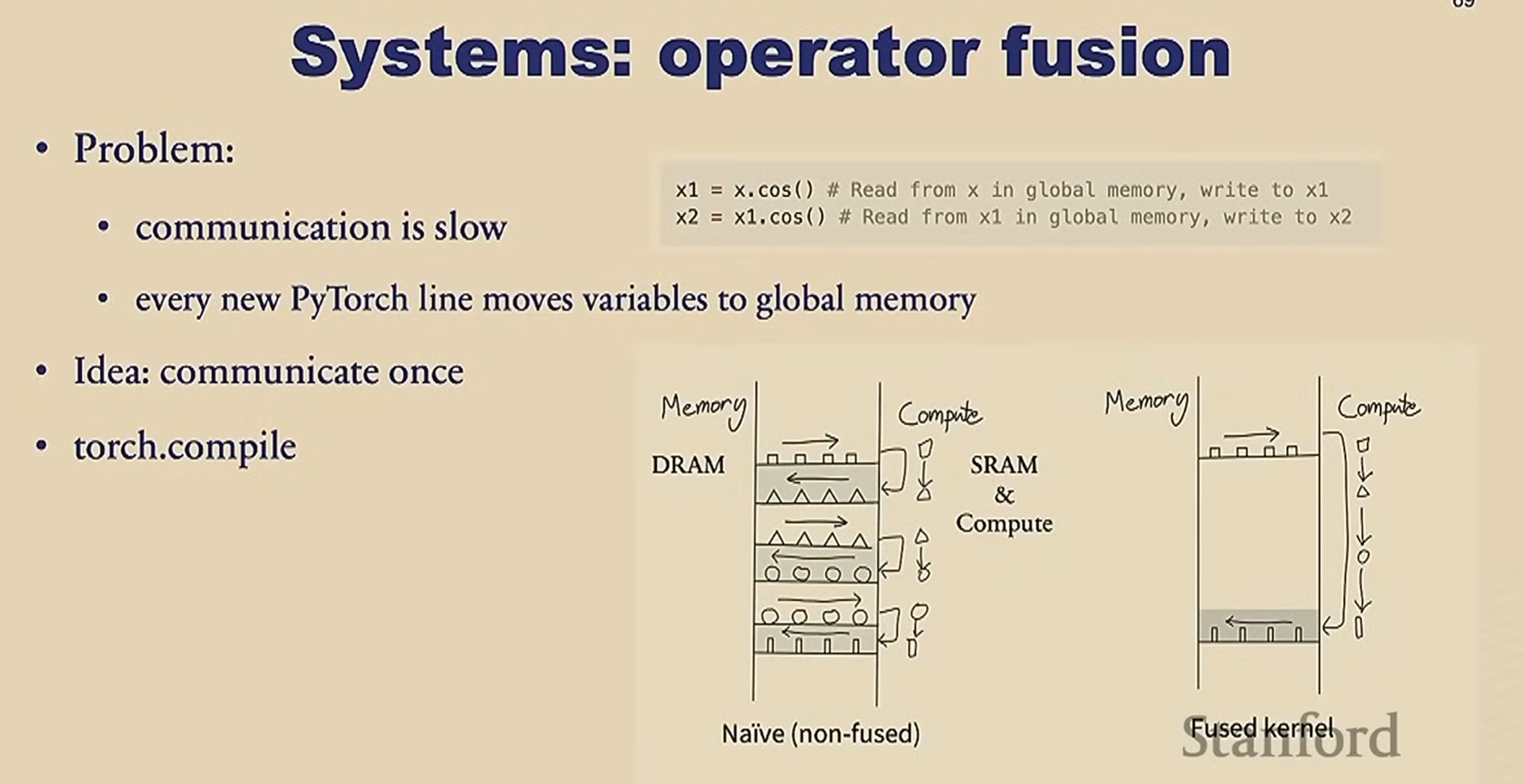

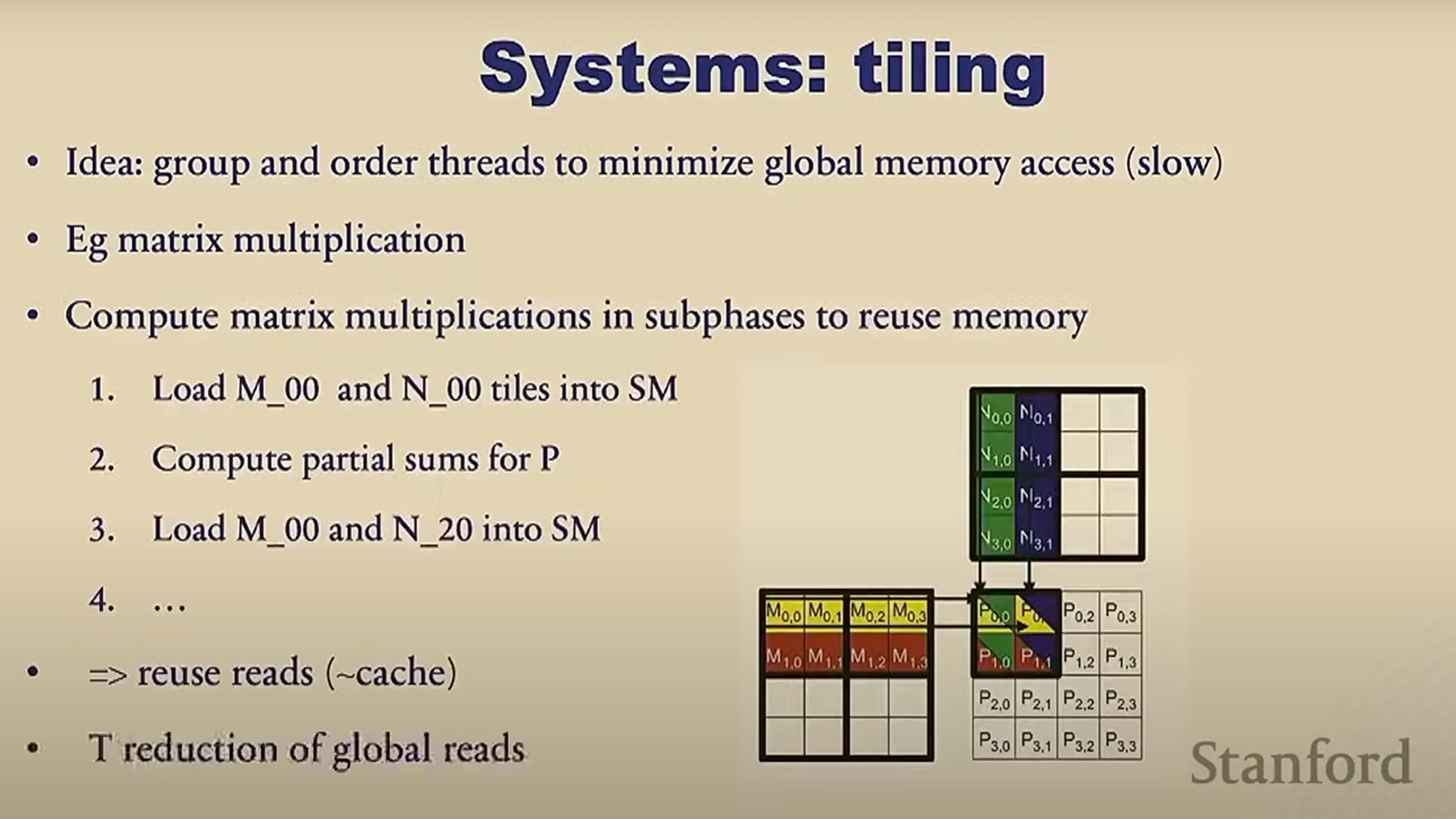

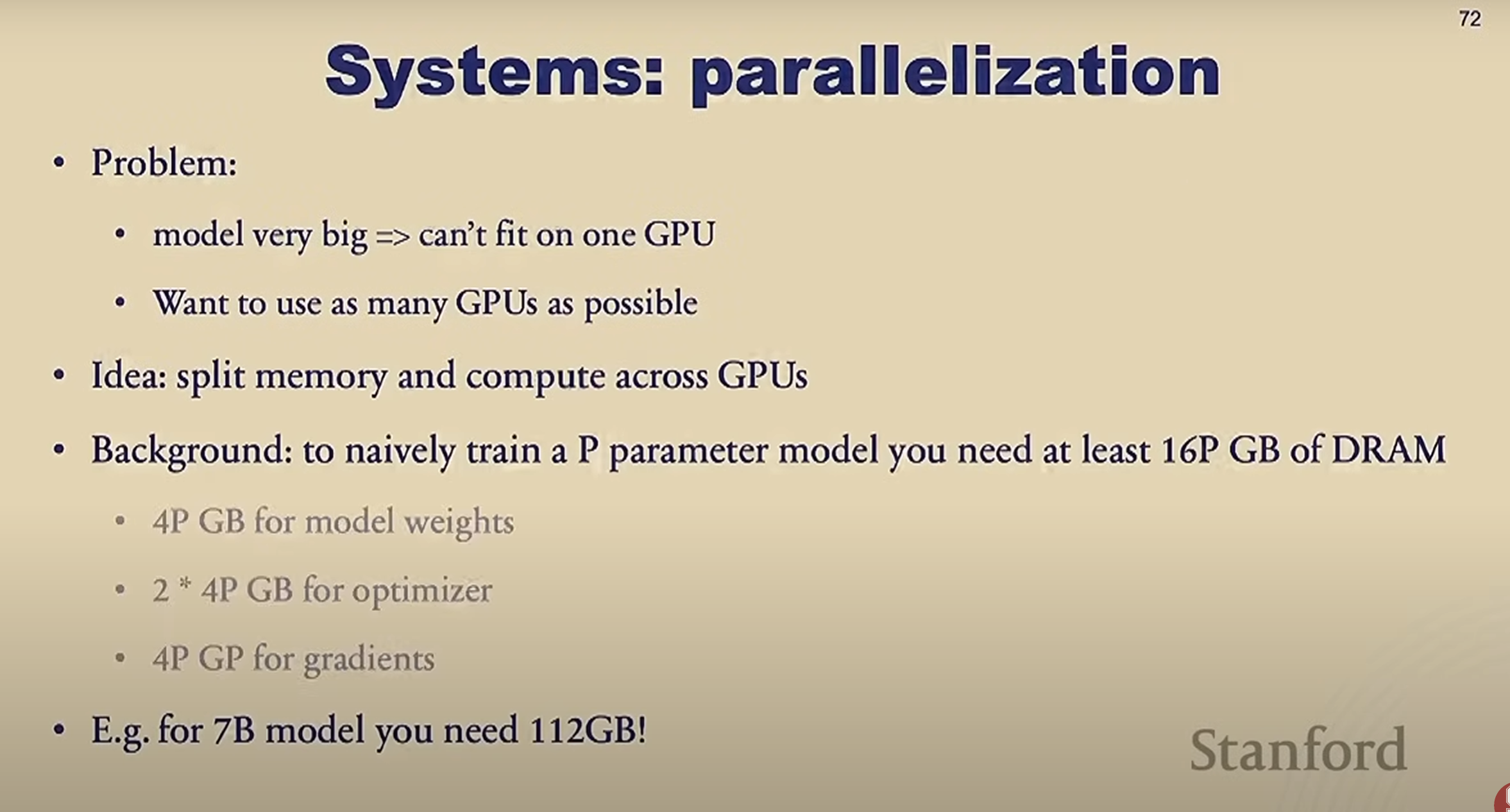

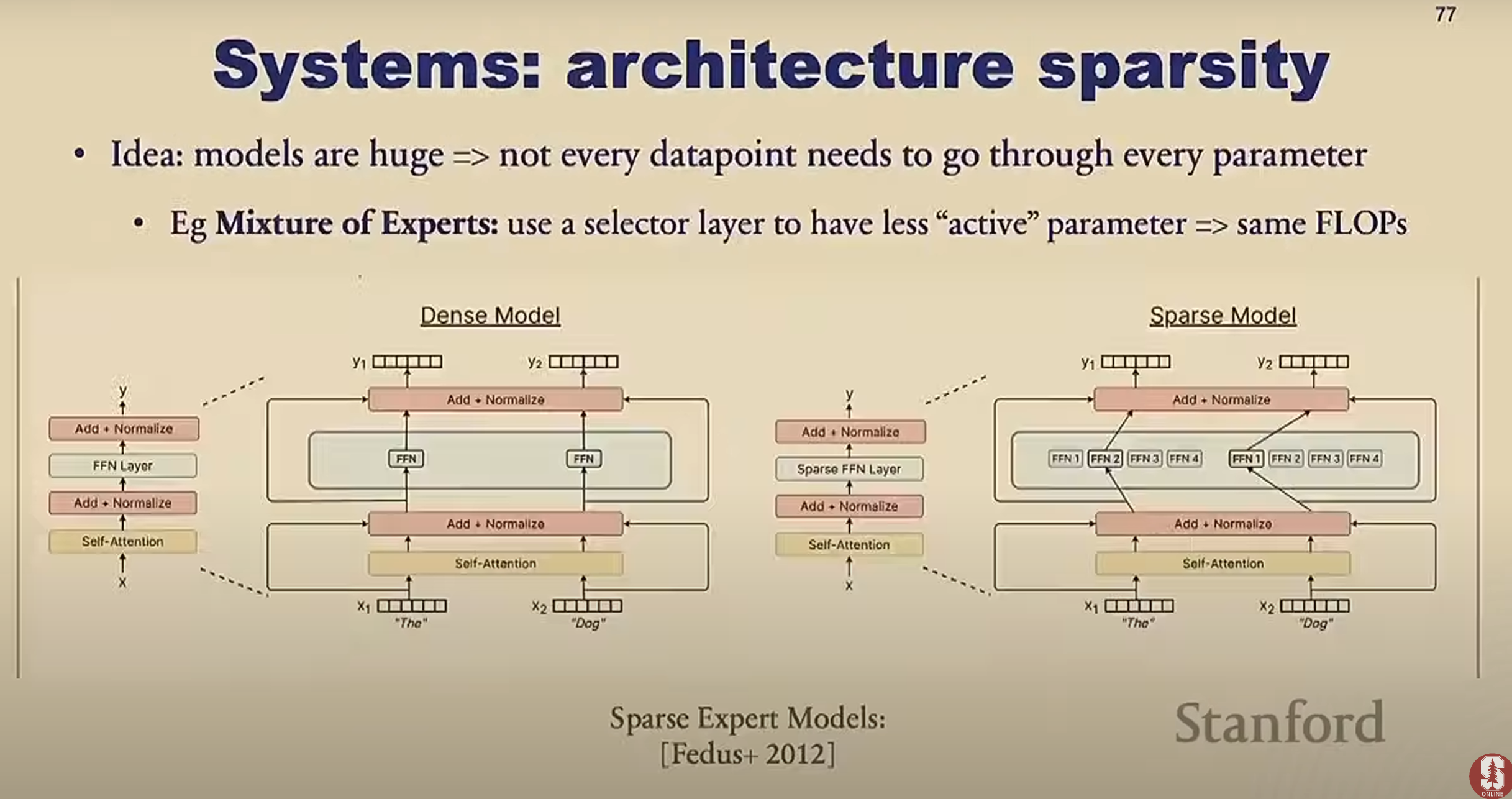

System

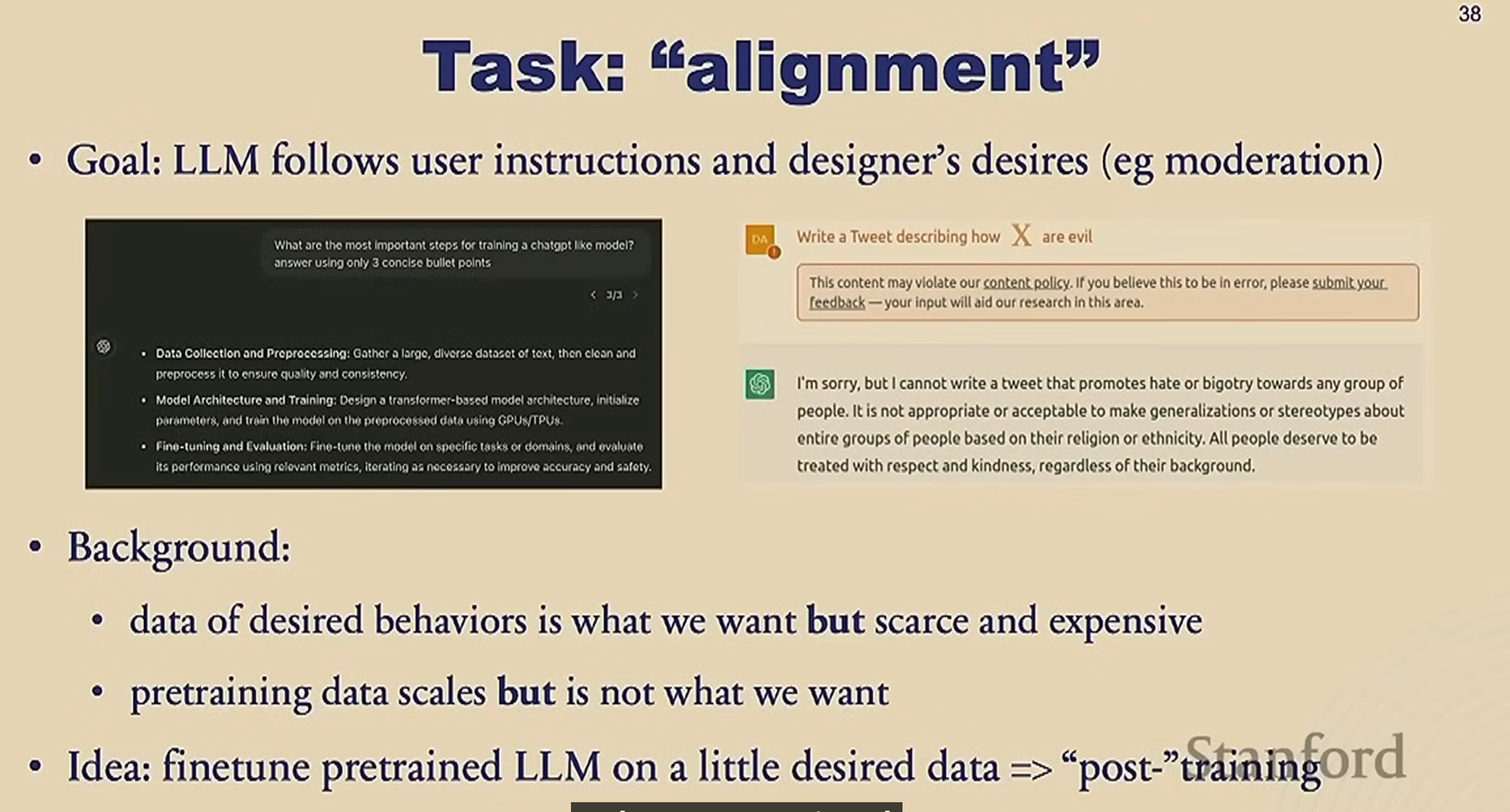

Post-training

alignment

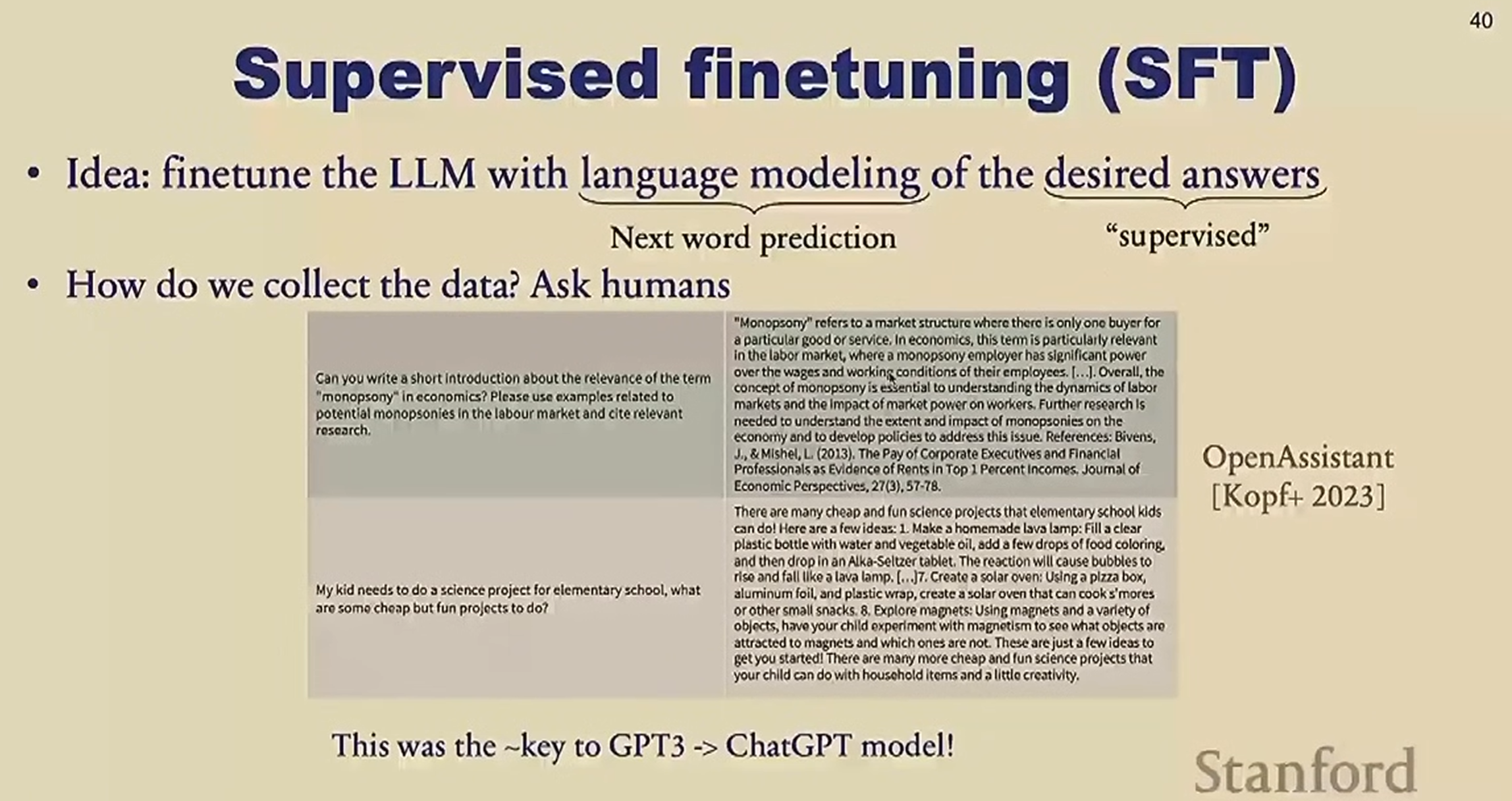

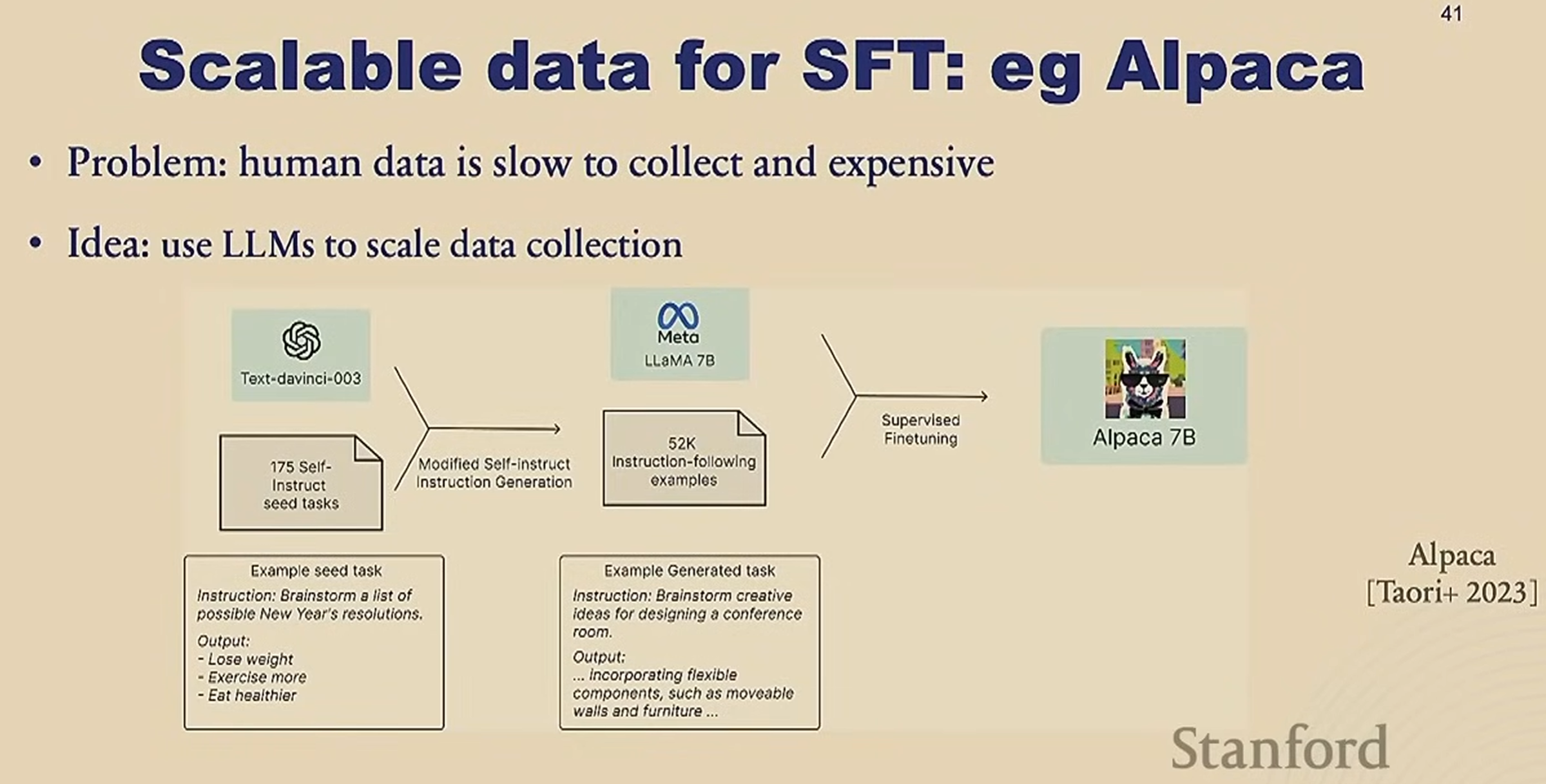

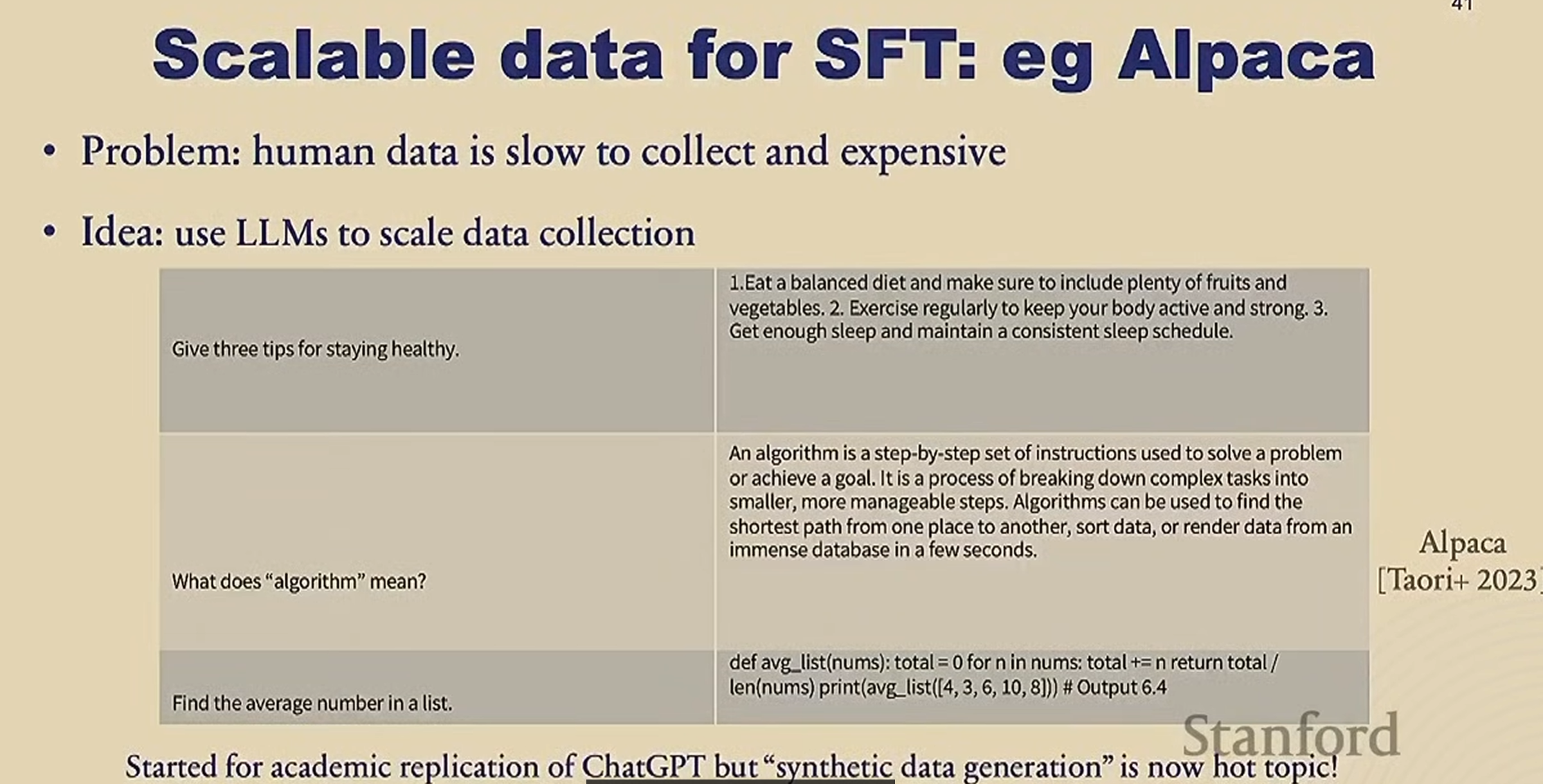

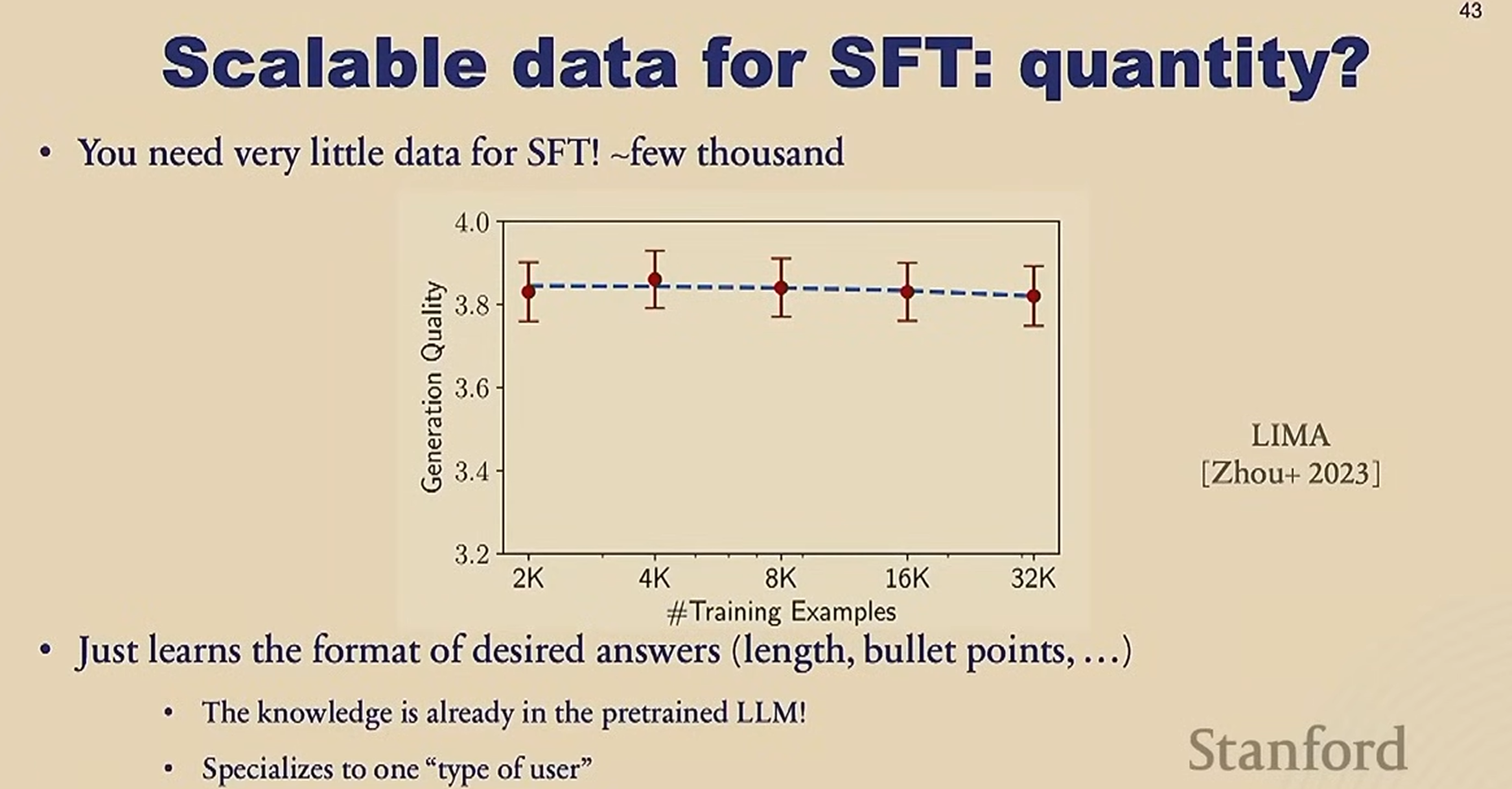

SFT Supervised finetuning

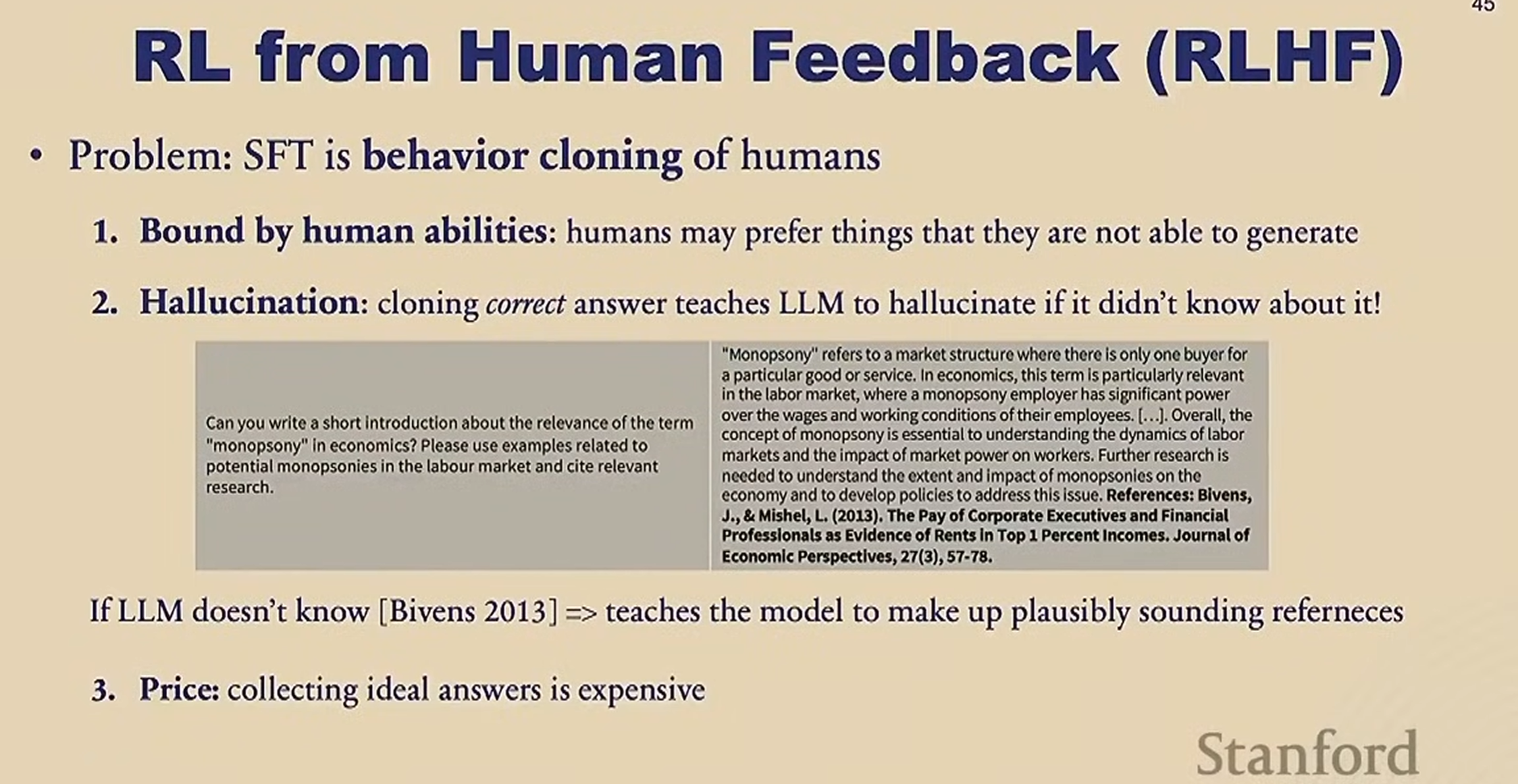

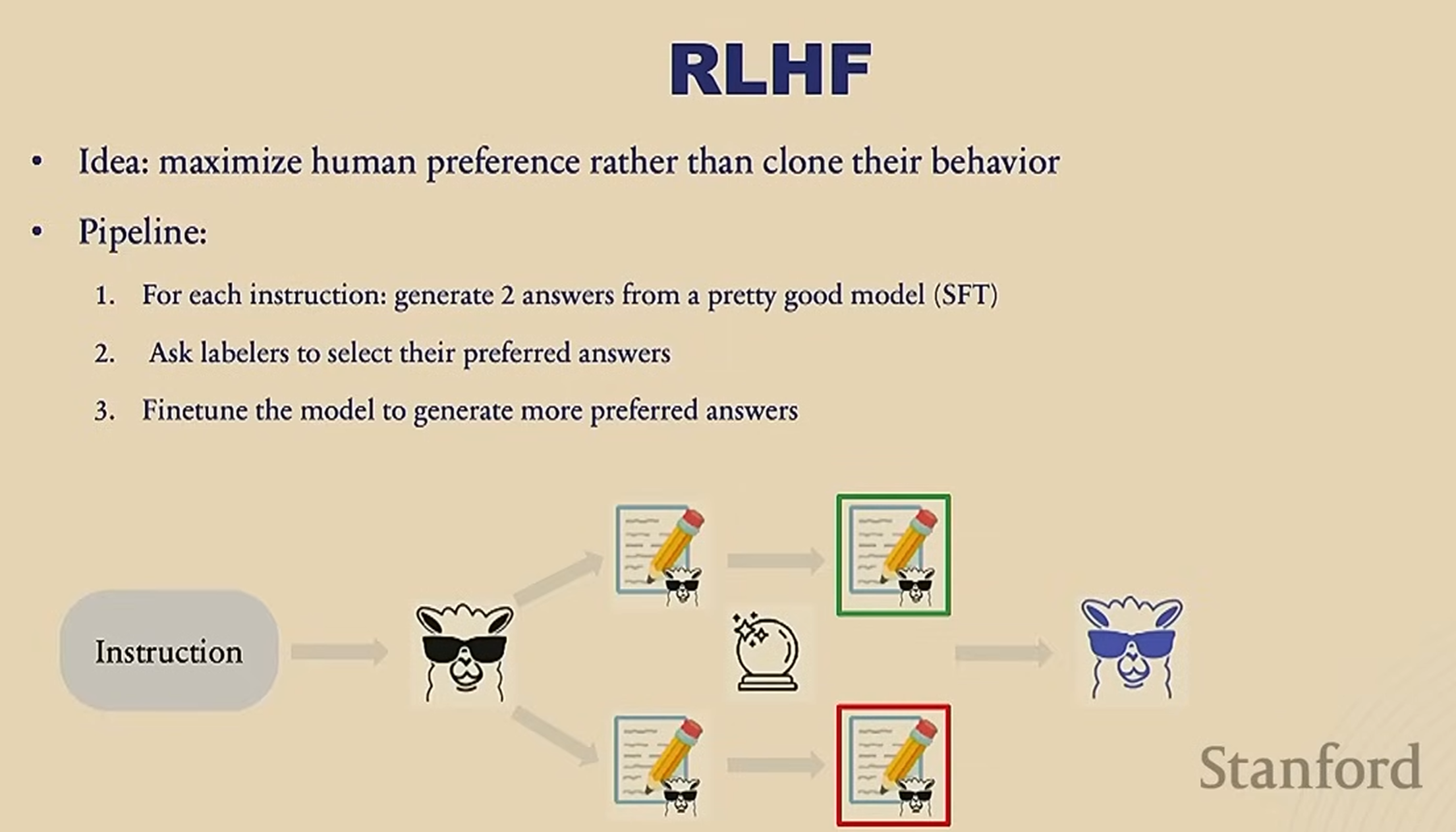

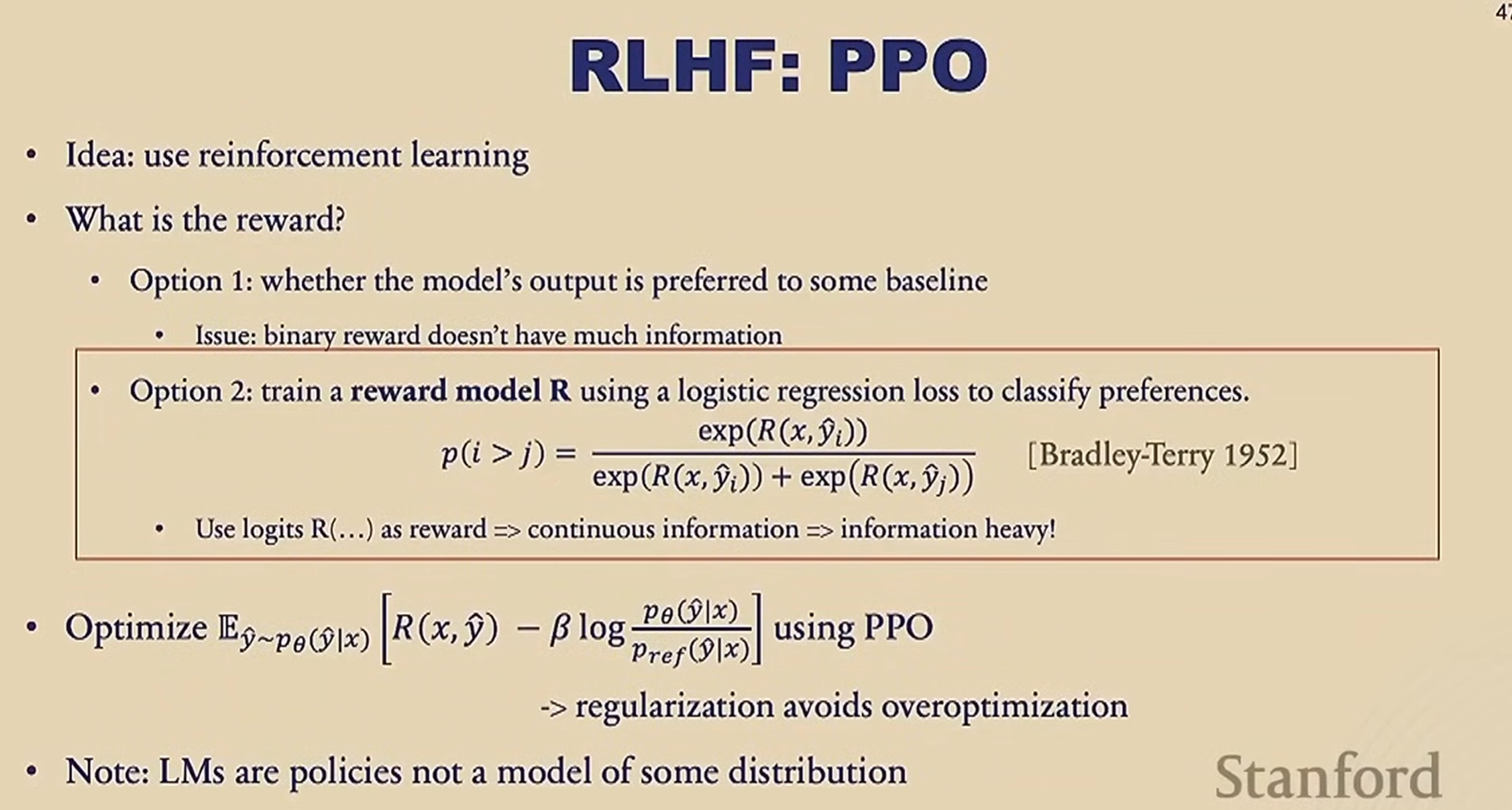

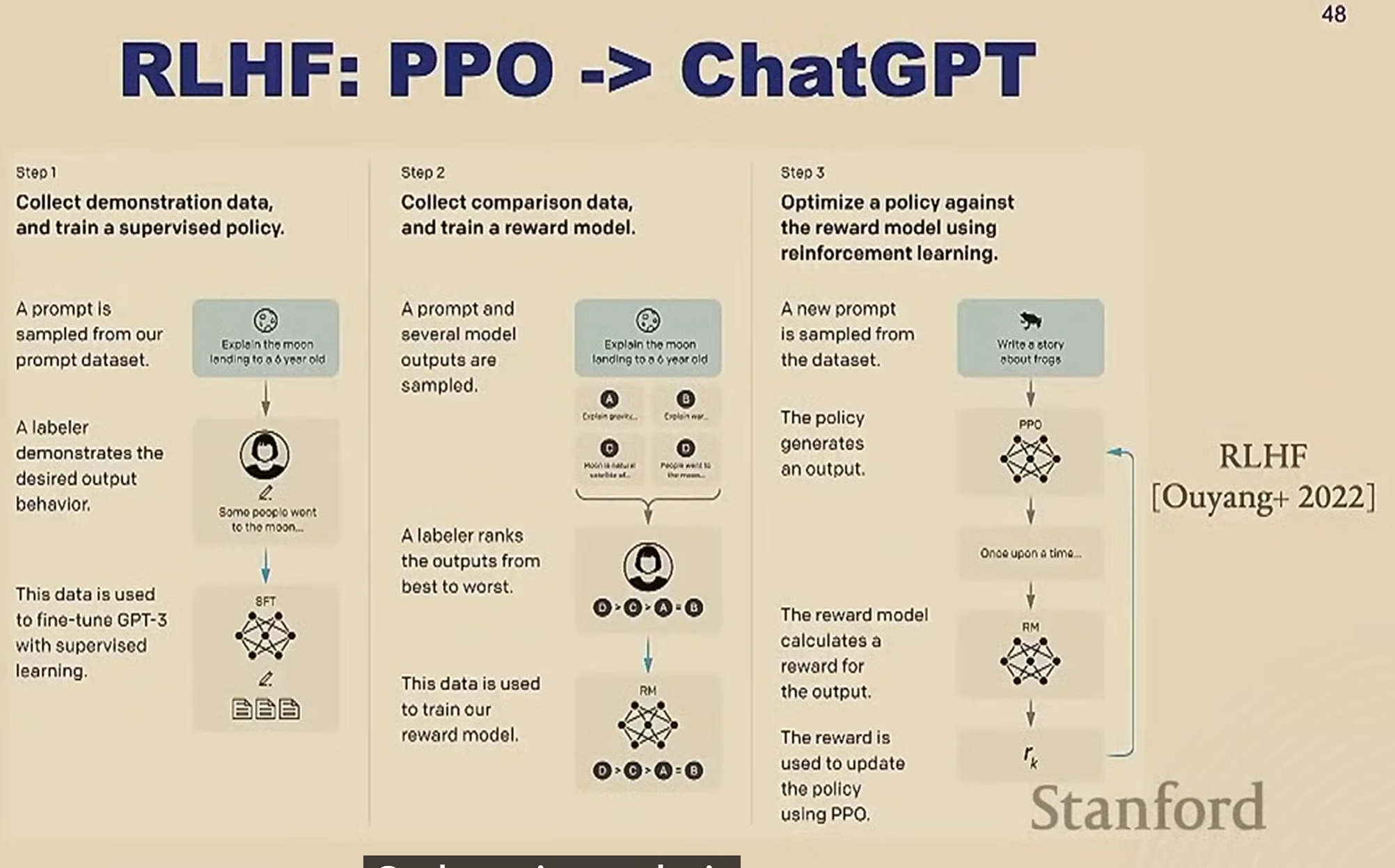

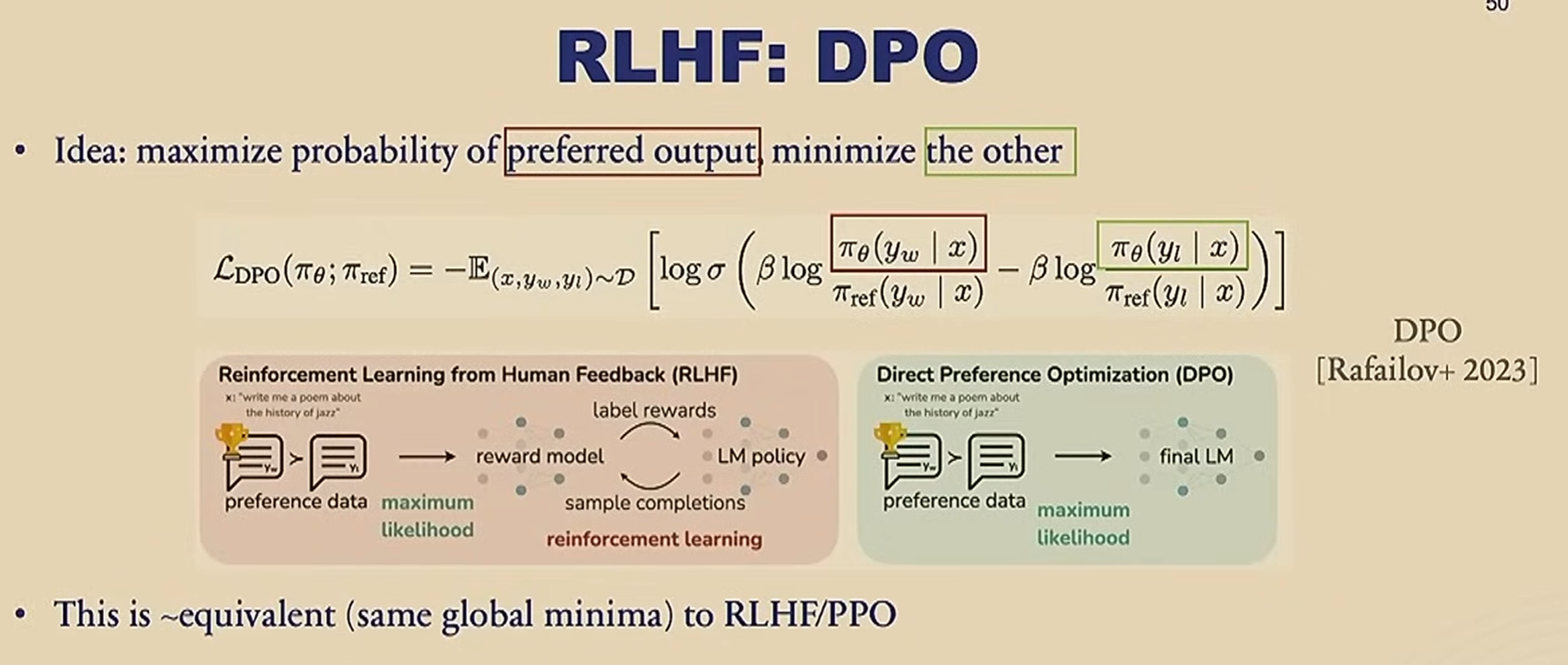

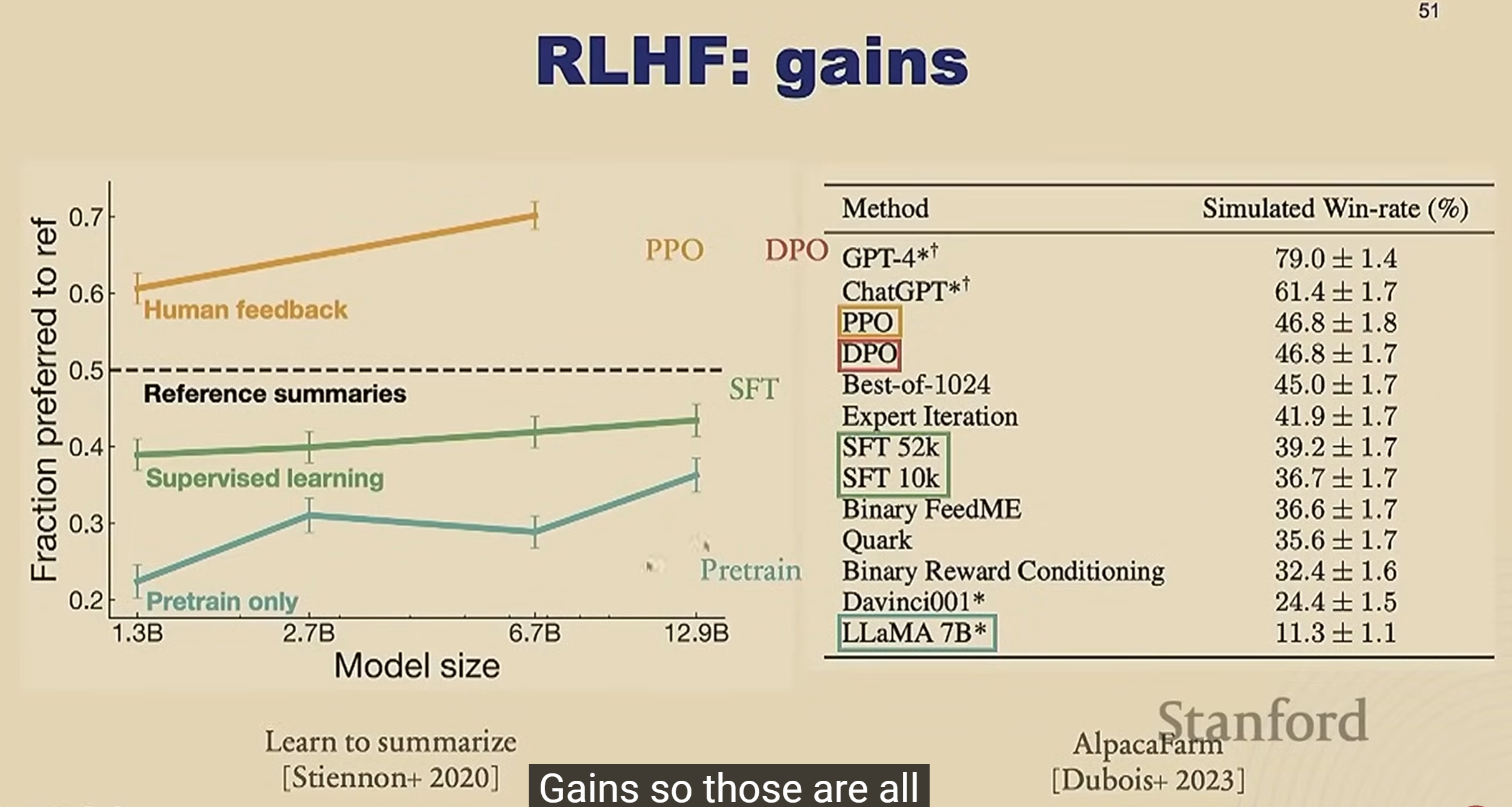

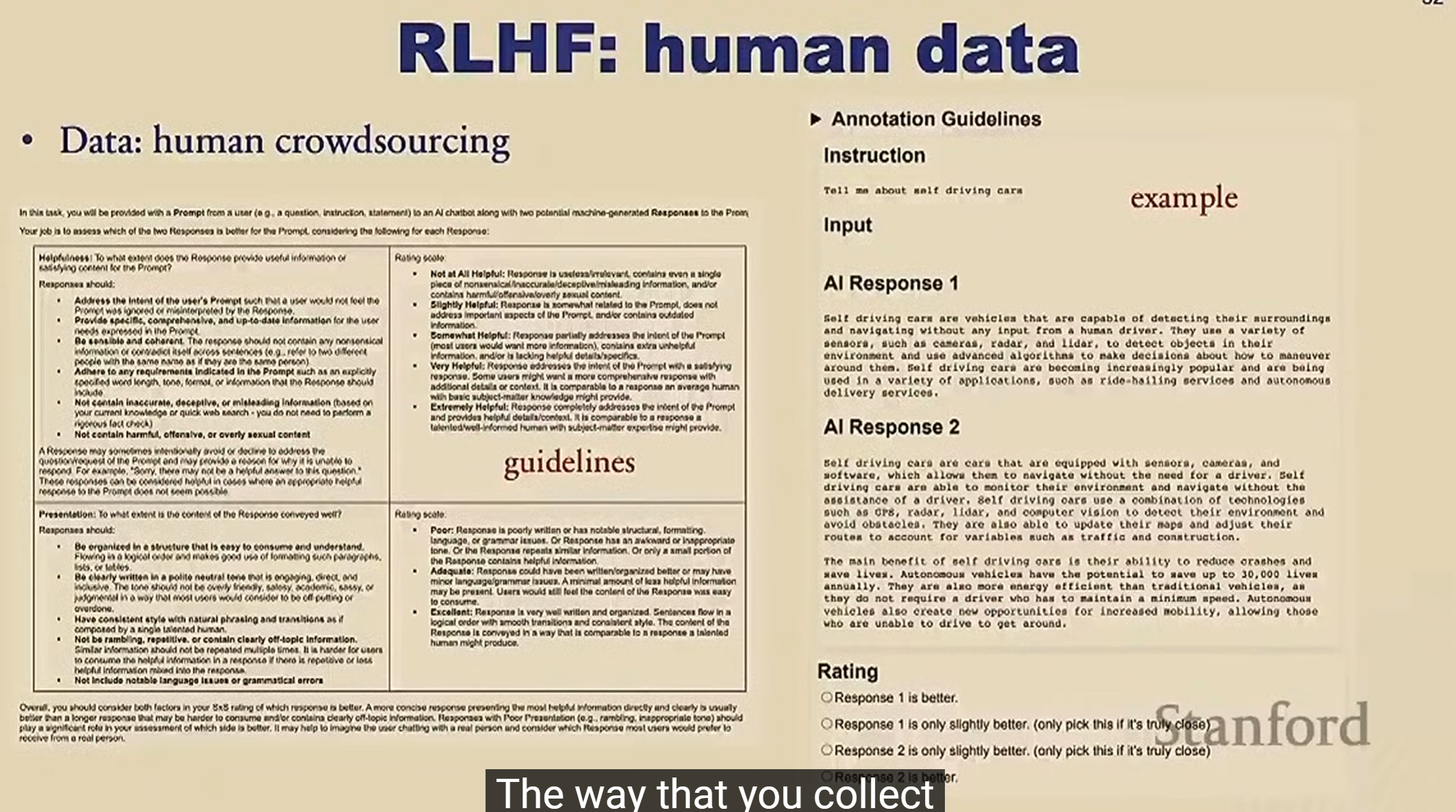

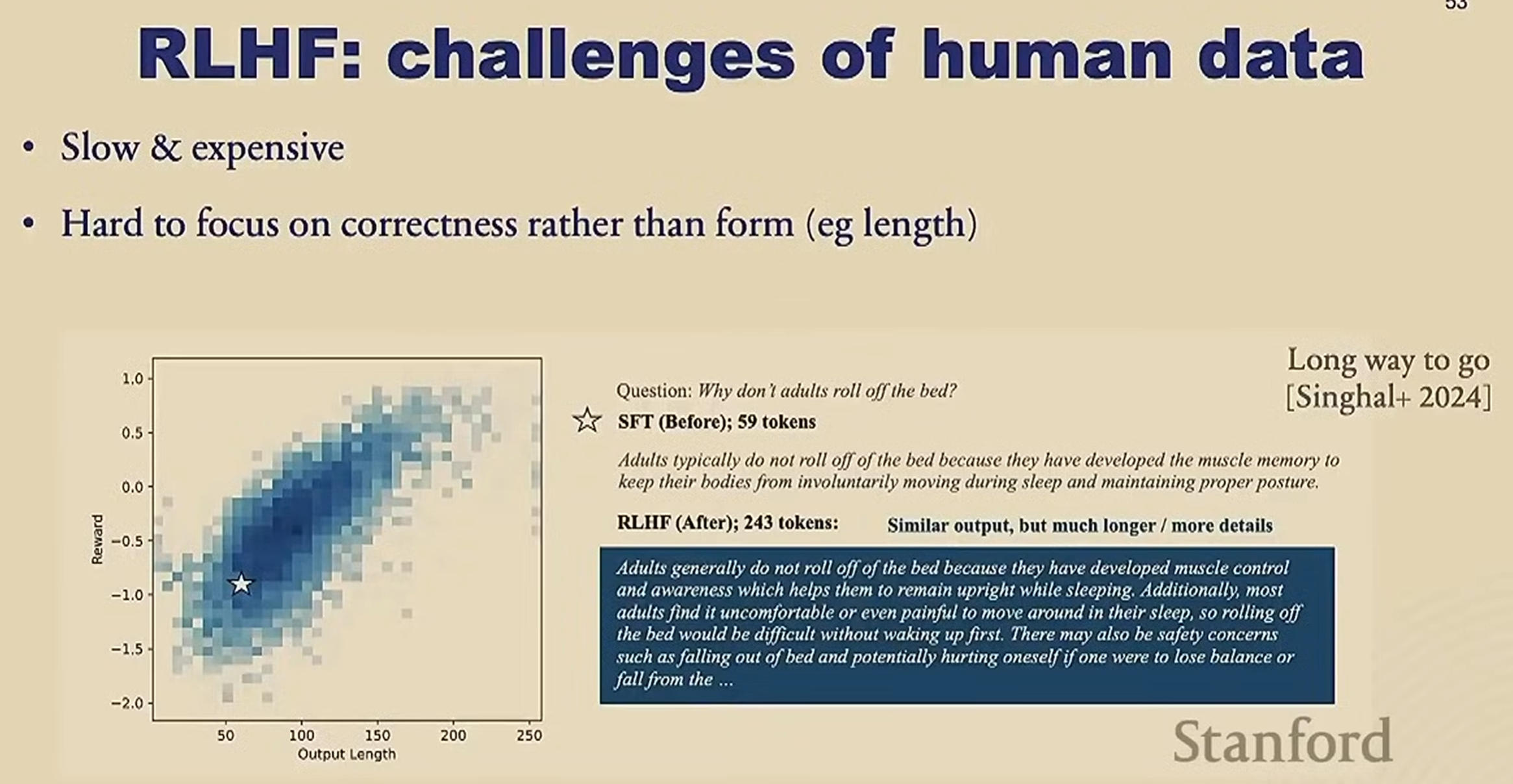

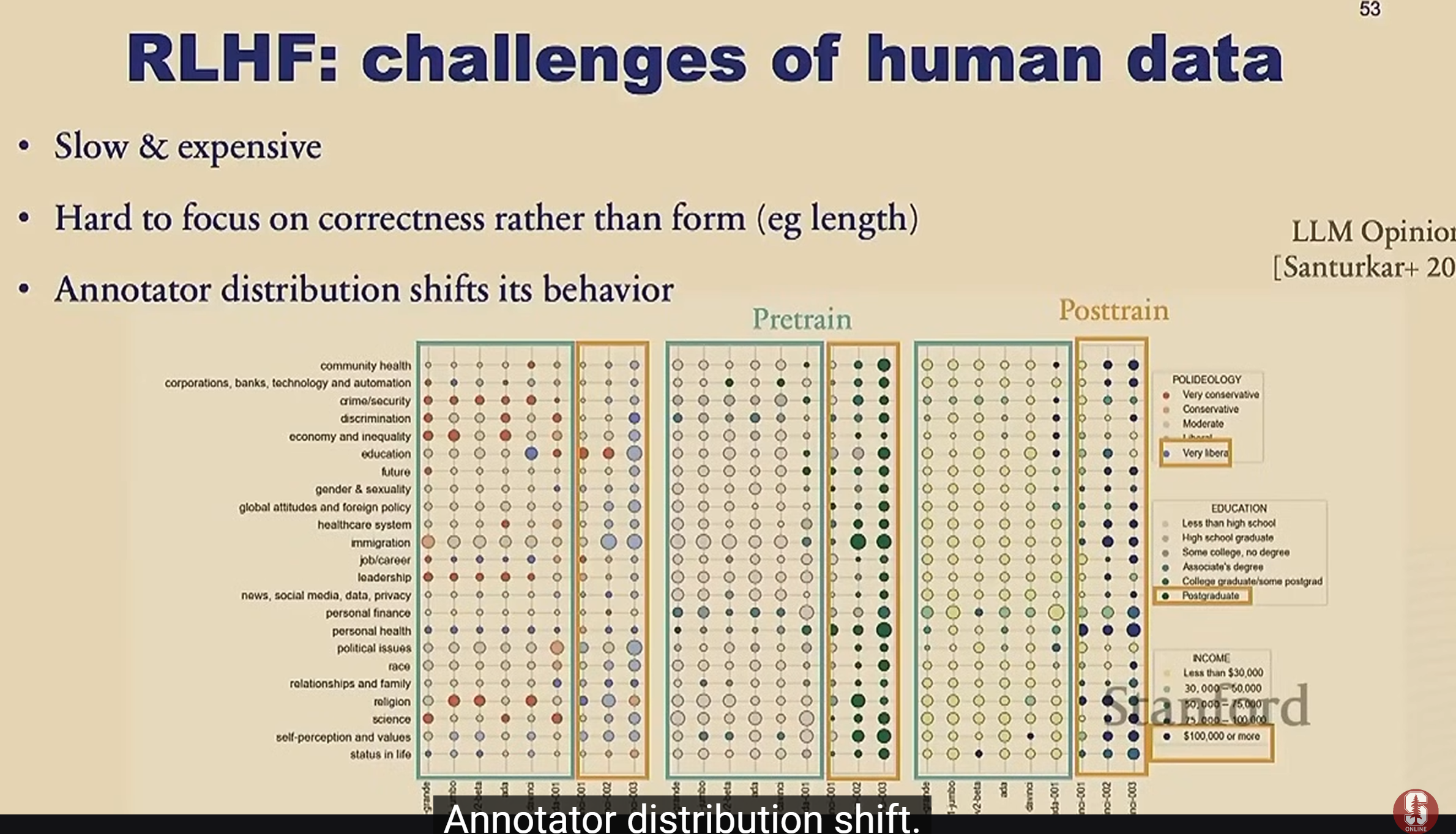

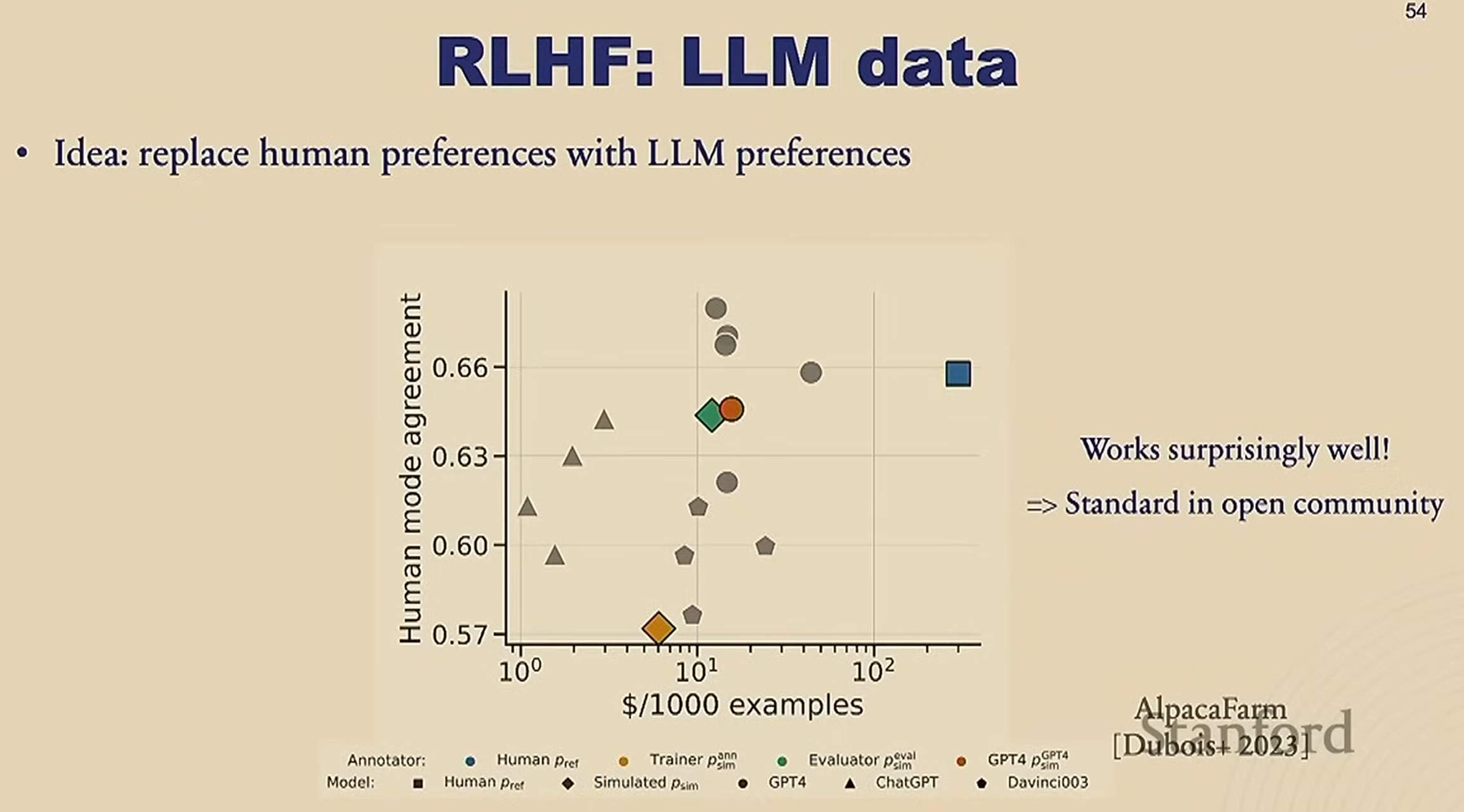

RLHF

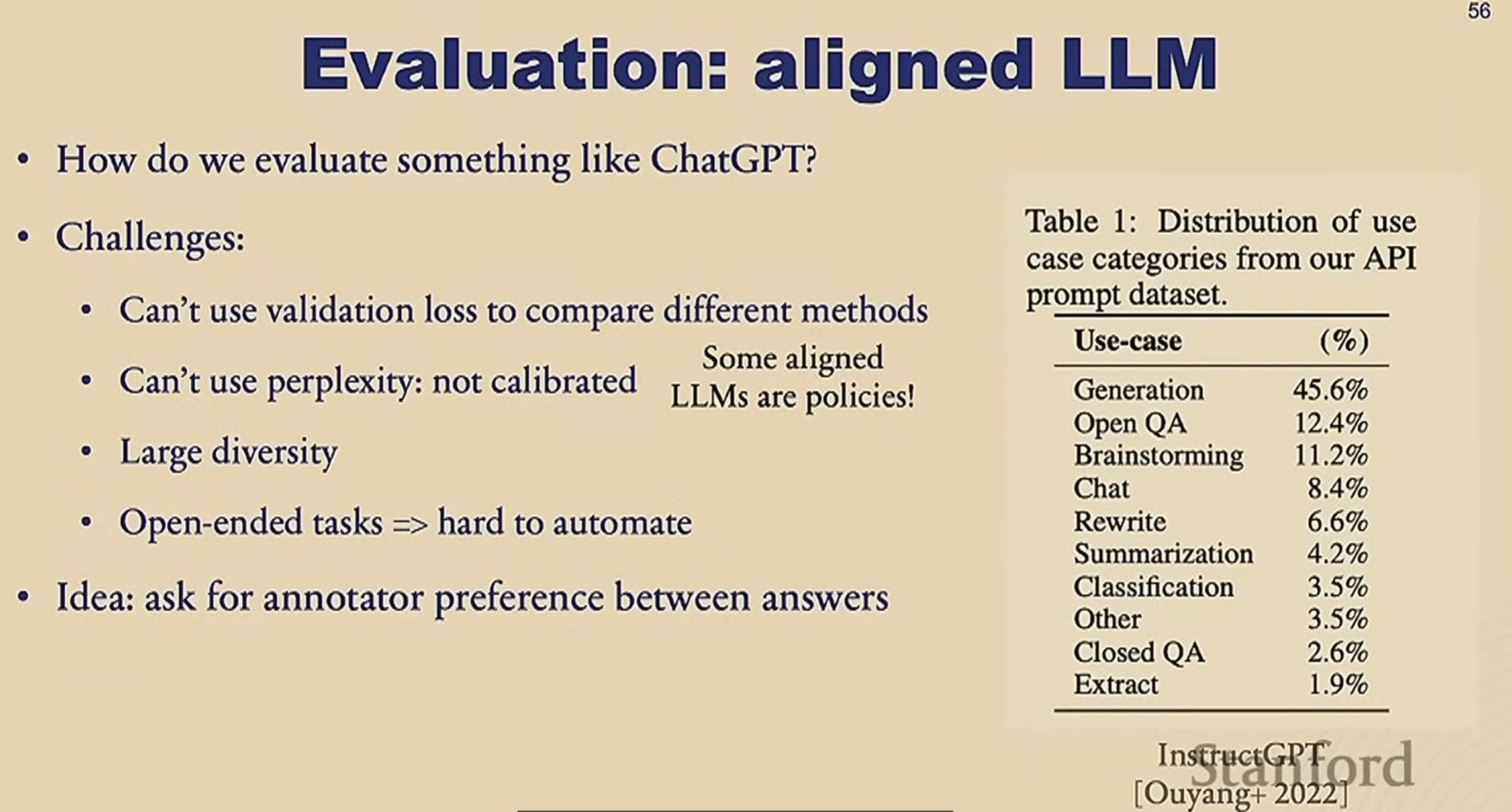

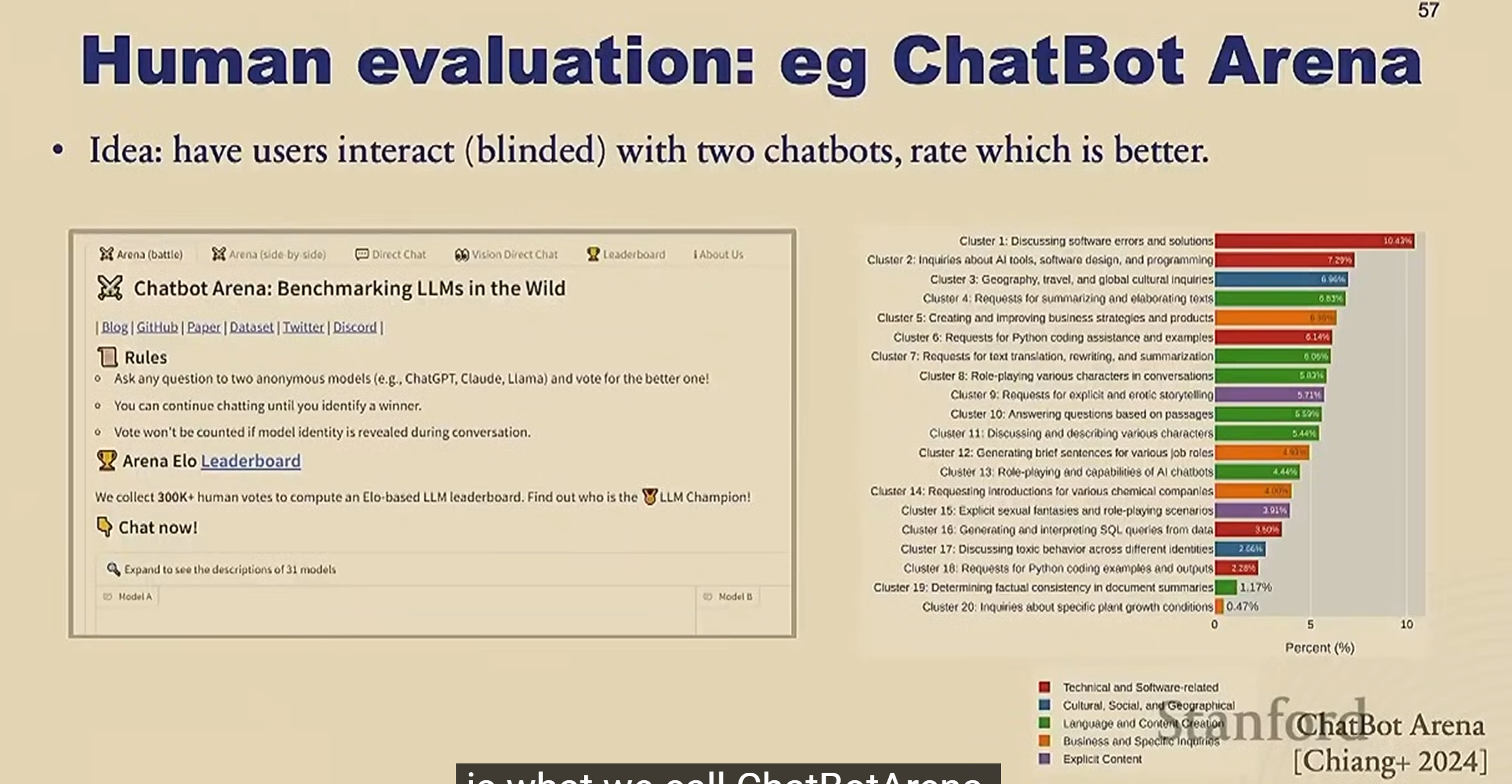

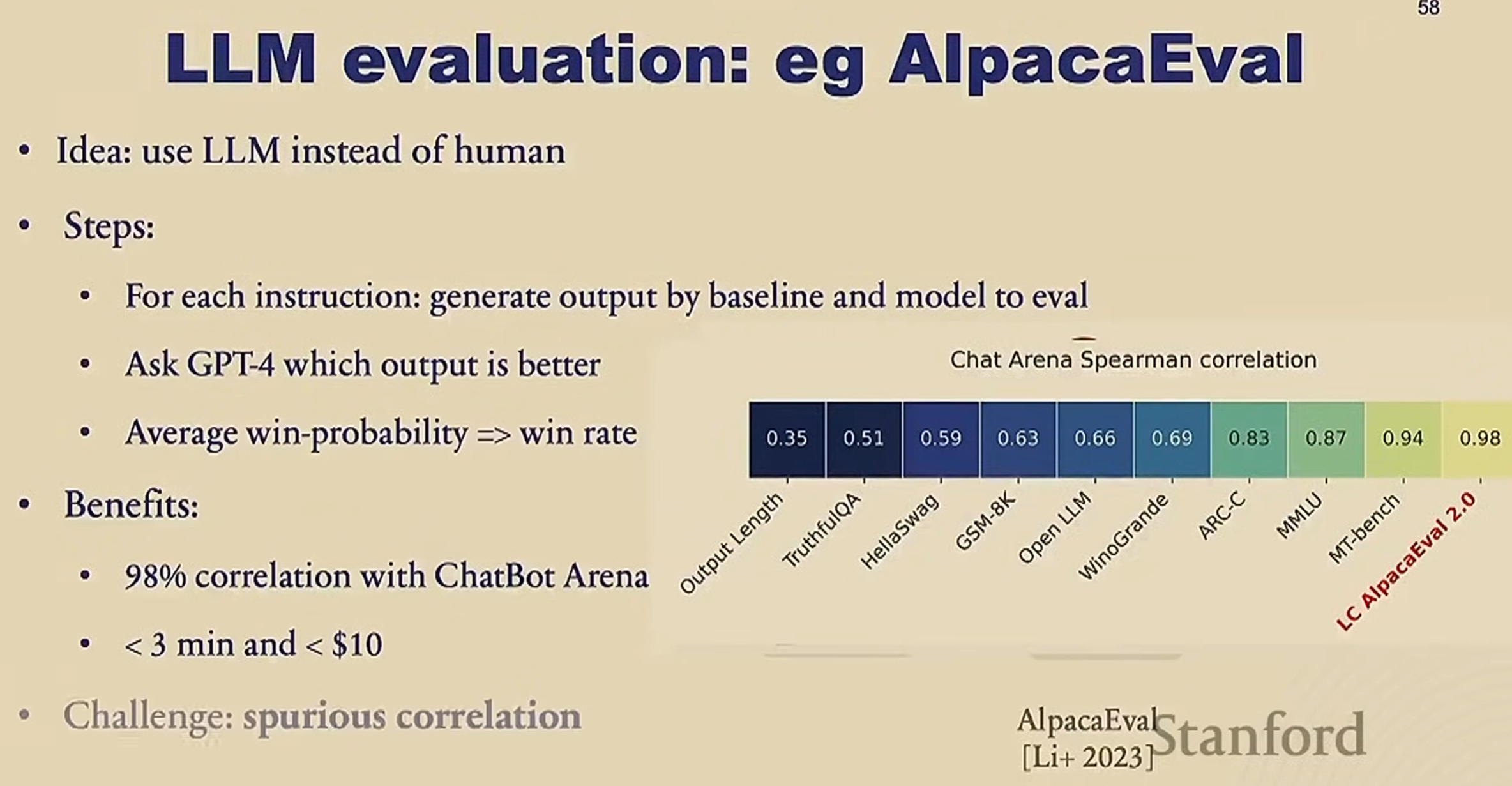

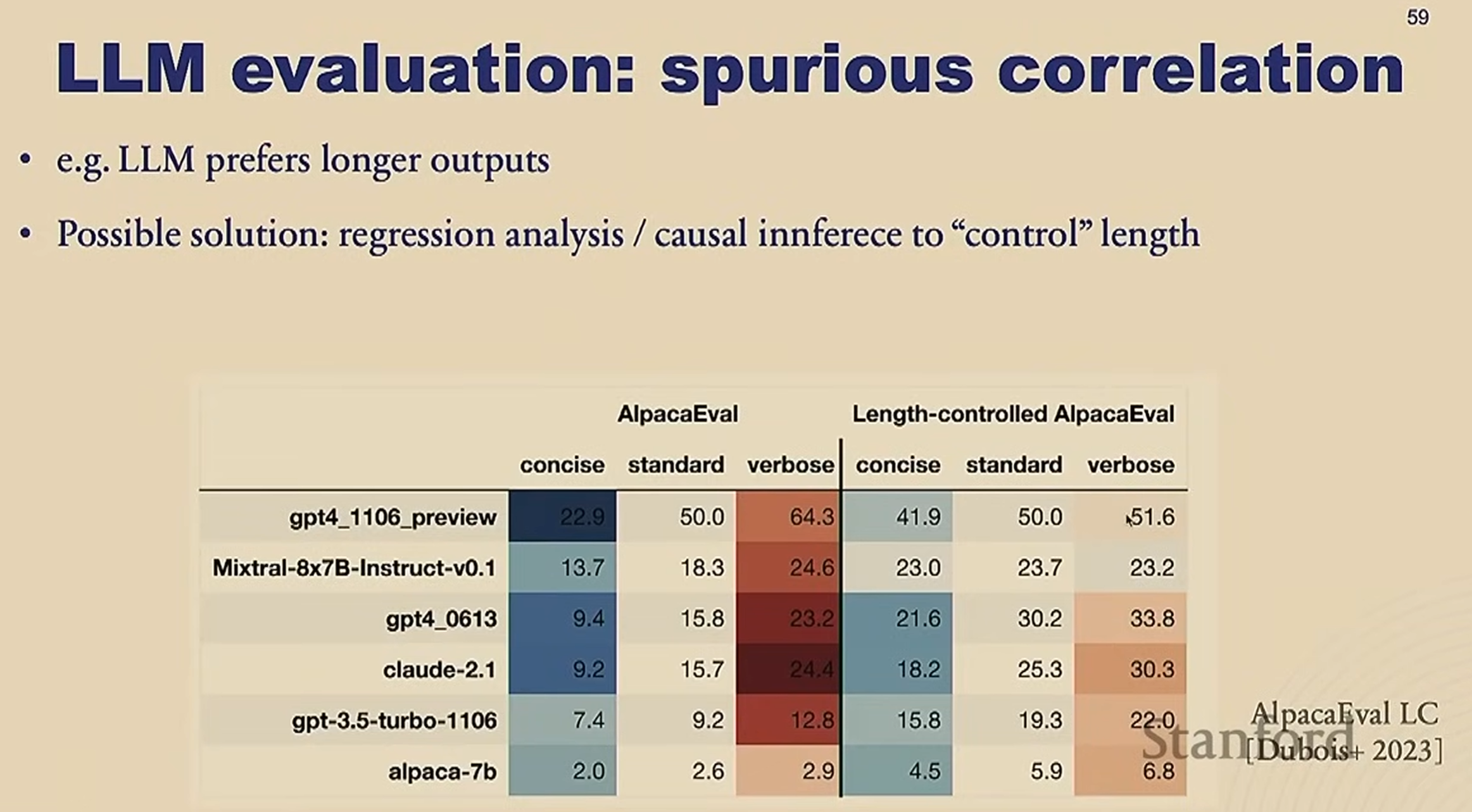

Evaluation

文档信息

- 本文作者:zuti666

- 本文链接:https://zuti666.github.io/2024/11/25/Note-LLM.-learning/

- 版权声明:自由转载-非商用-非衍生-保持署名(创意共享3.0许可证)